Framablog - Archives (janvier 2012)

Issu du monde éducatif, Framasoft est un réseau de sites web collaboratifs à géométrie variable dont le dénominateur commun est le logiciel libre.

On n’a pas le temps de souffler. Après SOPA, c’est ACTA qui est à repousser et avec la plus extrême vigueur. Pourquoi ? Vous le saurez en creux en parcourant ce court et percutant billet de Rick Falkvinge (que l’on traduit souvent actuellement).

Vous le saurez aussi et surtout en vous rendant sur la rubrique dédiée de La Quadrature qui nous fournit une excellente boîte à outils de résistance et mobilisation (sans oublier la pétition en ligne qui témoigne bien de la colère qui gronde).

La seule chose que vous devez savoir à propos d’ACTA

The only thing you need to know about ACTA

Rick Falkvinge - 28 janvier 2012 - Blog personnel

(Traduction Framalang/Twitter : kamui57, Cubox, Céline, Lamessen, NandS, eyome, HgO, Adrien)

ACTA a finalement repris de l’élan. Mais dans un document si conséquent, alambiqué et délibérément complexe, comment pouvez-vous déterminer vous-même s’il est bon ou mauvais ? Il existe une façon très simple de le dire.

La façon la plus simple de déterminer la nature d’ACTA ne se base pas sur le document lui-même, mais sur le comportement des gens le défendant.

Tous les acteurs, nous poussant et nous précipitant vers cet accord, ont insisté sur le fait qu’il ne changerait rien et, notamment, qu’aucun changement législatif ne serait nécessaire (en dehors de changements mineurs liés à la loi sur les marques, comme en Suède), et insistent surtout pour dire que ce n’est pas très important.

Par ailleurs, ces acteurs font pression de toutes leurs forces pour le faire passer. Ainsi, la principale question qui en ressort fait tâche :

Si l’ACTA ne change rien, pourquoi forcent-ils son passage comme si leur vie en dépendait ?

Et cette contradiction en elle-même suffit à démasquer l’ensemble de l’ACTA et ce que cela représente. Il a été négocié en secret par l’industrie du droit d’auteur et par les autres monopoles. Même maintenant, alors que les législateurs sont amenés à voter ce texte, il ne leur est pas laissé la possibilité de comprendre exactement ce que dit ce document – car beaucoup de nouvelles règles y sont définies mais ne sont valables que pour des protocoles d’échanges commerciaux. Ces derniers restant, néanmoins, secrets.

Si l’industrie du droit d’auteur fait pression de tout son poids pour faire passer quelque chose alors même qu’elle prétend que cela ne change rien, que pensez-vous que cela implique ?

C’est cette industrie qui pense qu’il est convenable pour les législateurs de leur donner le pouvoir de détruire un concurrent légal se trouvant à l’étranger, en supprimant ses revenus, son site web et ses publicités, simplement en le pointant du doigt.

C’est cette industrie qui trouve normal de pouvoir demander à se trouver en tête des résultats des moteurs de recherche, et de laisser “les miettes” à ses concurrents gratuits sous couvert de la loi.

C’est cette industrie qui demande sous la menace de la loi – une industrie privée – de mettre sur écoute électronique une population entière, seulement pour voir si des gens font quelque chose qu’elle n’apprécie pas, et dans ce cas, de couper à volonté les communications de cette population.

C’est cette industrie qui fait valoir que les citoyens devraient être activement empêchés d’exercer leurs droits fondamentaux, comme la liberté de parole et d’expression, si cela risque d’empiéter sur son business.

C’est cette industrie qui pense qu’il est raisonnable de condamner un petit faiseur de Karaoke à 1,2 1,2 milliards (3 000 000 €). Oh, et une grand-mère morte.

C’est cette industrie qui utilise la pédopornographie comme bouc émissaire de sa propre censure, et qui finalement choque les jeunes et favorise l’abus d’enfants.

C’est cette industrie qui a installé des rootkits sur les CD musicaux des gens et a pris le contrôle total de leurs ordinateurs, de millions d’appareils – comprenant les webcams, les microphones, les fichiers sur le disque dur, tout. Ils se sont maintenant introduits chez nous et y ont leurs yeux et leurs oreilles.

C’est cette industrie qui, une fois que vous la pensez au fond du gouffre tant moralement qu’humainement, revient sans cesse, avec de nouvelles façons créatives de vous surprendre.

Si cette industrie veut voir appliquer ce texte législatif incroyablement mauvais. Si elle se bat pour lui comme pour sa propre vie tout en prétendant que ce n’est pas très important. Si elle se bat sans expliquer aux législateurs en quoi consiste le texte. Cela devrait suffire à n’importe qui pour réaliser que c’est un sombre concentré d’horreurs. Attendez-vous à ce que l’ACTA légalise des pratiques semblables aux exemples précédents. Et encore plus. Attendez-vous à voir pire, bien pire que SOPA.

Il y a un mois Cory Doctorow a donné une conférence remarquable et remarquée lors du fameux CCC de Berlin.

Tellement remarquée qu’il a décidé d’en faire a posteriori un long mais passionnant article dont nous vous proposons la traduction aujourd’hui (merci @ricomoro)[1].

La guerre contre le copyright préfigure une guerre totale contre les ordinateurs et donc nos libertés d’utilisateurs. C’est pourquoi il est fondamental de la gagner…

On ferme

La guerre imminente contre nos libertés d’utilisateurs

Lockdown - The coming war on general-purpose computing

Cory Doctorow - 10 janvier 2012 - BoingBoing

(Traduction Framalang : Don Rico - Relecture : Goofy)

Cet article reprend une intervention donnée au Chaos Computer Congress de Berlin, en décembre 2011.

Les ordinateurs sont époustouflants. À tel point que notre société ne sait toujours pas très bien les cerner, peine à comprendre exactement à quoi ils servent, par quel bout les prendre, et comment se débrouiller avec. Ce qui nous ramène à un sujet sur lequel on a écrit ad nauseam : le copyright.

Mais je vous demande un peu de patience, car je vais aborder ici une question plus importante. La forme que prend la guerre contre le copyright présage d’un combat imminent qui se livrera pour le destin de l’ordinateur lui-même.

Aux débuts de l’informatique grand public, nous achetions les logiciels dans des emballages et nous échangions des fichiers de la main à la main. On trouvait les disquettes dans des sachets hermétiques, dans des cartons, alignées dans des rayons à la façon des paquets de gâteaux et des magazines. Rien n’était plus facile que de les dupliquer, la copie était très rapide et très répandue, au grand dam des concepteurs et des vendeurs de logiciels.

Arrivent les verrous numériques (les DRM), dans leurs formes les plus primitives – nous les appellerons DRM 0.96. Pour la première fois, on eut recours à des marqueurs physiques – dégradation délibérée, dongles, secteurs cachés – dont le logiciel contrôlait la présence, ainsi qu’à des protocoles défi-réponse qui nécessitaient de posséder des modes d’emploi encombrants et difficiles à copier.

Ces mesures échouèrent pour deux raisons. Premièrement, elles connurent une grande impopularité commerciale, car elles réduisaient l’utilité du logiciel pour ceux qui le payaient. Les acquéreurs honnêtes voyaient d’un mauvais œil que leurs sauvegardes ne soient pas utilisables, n’appréciaient guère de perdre un de leurs ports, déjà rares, à cause des clés matérielles d’autentification, et s’irritaient de devoir manipuler de volumineux modes d’emploi lorsqu’ils souhaitaient lancer leur logiciel. Deuxièmement, ces mesures ne découragèrent pas les pirates, pour qui patcher le logiciel et contourner l’authentification était un jeu d’enfant. L’effet fut nul sur ceux qui se procuraient le logiciel sans le payer.

En gros, cela ce passait ainsi : un programmeur, possédant du matériel et des compétences du même niveau de sophistication que l’éditeur du logiciel, décortiquait le programme par rétro-ingénierie et en diffusait des versions crackées. Un tel procédé peut paraître très pointu, mais en fait, il n’en était rien. Comprendre le fonctionnement d’un programme récalcitrant et contourner ses défauts constituaient les compétences de base de tout programmeur, surtout à l’époque des fragiles disquettes et des débuts balbutiants du développement logiciel. Les stratégies destinées à combattre la copie devinrent plus inutiles encore lorsque les réseaux se développèrent. À l’apparition des BBS, services en ligne, newsgroups Usenet et listes de diffusion, le résultat du travail de ceux qui parvenaient à surmonter les systèmes d’authentification put être distribué sous forme de logiciel, dans de petits fichiers de crack. Lorsque les capacités du réseau s’accrurent, on put diffuser directement les images disque ou les exécutables crackés.

Vinrent alors les DRM 1.0. En 1996, il devint évident dans les lieux de pouvoir qu’un bouleversement d’envergure allait se produire. Nous allions entrer dans une économie de l’information, sans qu’on sache trop ce qu’était ce machin. Nos élites supposèrent que ce serait une économie où l’on achèterait et vendrait de l’information. La technologie de l’information améliore l’efficacité, alors imaginez un peu les marchés potentiels qui s’offraient à nous ?! On allait pouvoir acheter un livre pour une journée, vendre le droit de visionner un film pour un euro, puis louer le bouton pause pour un centime la seconde. On allait pouvoir vendre des films à un certain prix dans un pays, à un prix différent dans un autre, etc. Les fantasmes de l’époque ressemblaient à une adaptation SF ennuyeuse du Livre des Nombres de l’Ancien Testament, une énumération fastidieuse de toutes les combinaisons possibles de ce qu’on fait avec l’information, et combien chacune allait être facturée.

Hélas pour eux, rien de tout cela n’était possible à moins de pouvoir contrôler la façon dont nous utilisions nos ordinateurs, et les fichiers que nous y transférions. En fait, il était facile d’envisager de vendre à quelqu’un des morceaux de musique à télécharger sur un lecteur MP3, mais plus compliqué d’envisager le droit de transférer une chanson du lecteur vers un autre appareil. Comment en effet en empêcher les acheteurs une fois qu’on leur a vendu le fichier ? Pour cela, il fallait trouver un moyen d’interdire aux ordinateurs d’exécuter certains programmes, d’inspecter certains fichiers et processus. Par exemple, pourquoi ne pas chiffrer le fichier, puis exiger de l’utilisateur qu’il le lise avec un lecteur audio qui ne le déverouillerait que sous des conditions précises ?

Mais là, comme on dit sur internet, on se retrouve avec deux problèmes.

Il faut à présent empêcher l’utilisateur d’enregistrer le fichier après qu’il a été déchiffré – ce qui se produira un jour ou l’autre –, et faire en sorte que l’utilisateur ne découvre pas où le programme de déverrouillage entrepose ses clés, ce qui lui permettrait de déchiffrer le média de façon permanente et se débarrasser une bonne fois pour toutes de leur lecteur audio à la con.

Voilà donc un troisième problème : il faut empêcher les utilisateurs qui parviennent à déchiffrer le fichier de le partager. Un quatrième problème se pose alors, car ces utilisateurs qui réussissent à arracher leurs secrets aux programmes de déverrouillage, il faut les empêcher d’expliquer à d’autres comment procéder. S’ajoute au tout un cinquième problème, parce que les utilisateurs qui comprennent comment extraire ces secrets, il faut les empêcher de les dévoiler à d’autres !

Ça fait un paquet de problèmes. Mais en 1996, on trouva la solution. L’Organisation mondiale de la propriété intellectuelle des Nations Unies signa le Traité de l’OMPI sur le droit d’auteur. Ce traité engendra des lois qui rendaient illégal d’extirper les clés secrètes des programmes de déverrouillage, d’extraire des fichiers média (tels que des chansons ou des films) de ces programmes de déverrouillage lors de leur fonctionnement. On vota des lois qui rendaient illégal d’expliquer à ses pairs comment extirper les clés secrètes des programmes de déverrouillage, ainsi que d’héberger ces mêmes clés ou des œuvres placées sous copyright. Grâce à ce traité, on mit également en place un procédé bien ficelé et fort commode qui permet de faire retirer du contenu d’internet sans avoir à se coltiner avocats, juges, et tous ces emmerdeurs.

Après quoi, la copie illégale fut éradiquée, l’économie de l’information s’épanouit pour devenir une fleur splendide qui apporta la prospérité au monde entier. Comme on dit sur les porte-avions, « Mission accomplie ».

Non. Ce n’est pas ainsi que l’histoire se termine, bien sûr, car presque tous ceux qui maîtrisaient les ordinateurs et les réseaux comprirent que ces lois allaient créer plus de problèmes qu’elles ne pourraient en résoudre. Après tout, ces lois rendaient illégal le fait de regarder dans le ventre de son ordinateur pendant qu’il exécutait certains programmes. À cause d’elles, il était illégal de raconter à d’autres ce qu’on avait découvert sous le capot, et plus facile que jamais de censurer des fichiers sur internet sans devoir justifier d’une infraction.

En résumé, ces lois soumettaient des exigences irréalistes à la réalité, qui a refusé de s’y plier. Depuis le vote de ces lois, il est au contraire devenu plus facile de copier – et cette tendance ne s’inversera jamais. Il ne sera toujours plus aisé de copier demain qu’aujourd’hui. Vos petits-enfants vous demanderont : « Raconte-moi encore, papi, comme c’était compliqué de copier des fichiers, en 2012, quand on n’avait pas de disque de la taille d’un ongle sur lequel on peut stocker tous les albums jamais enregistrés, tous les films jamais tournés, tous les textes jamais écrits, toutes les photos jamais prises, absolument tout, et les transférer en un temps si court qu’on ne s’en rend même pas compte ! »

La réalité reprend toujours ses droits. Il existe une comptine dans laquelle une femme gobe une araignée pour attraper une mouche, avale ensuite un oiseau pour attraper l’araignée, et enfin un chat pour attraper l’oiseau. Il en va de même pour ces réglementations, qui semblent très prometteuses sur le papier, mais se révèlent désastreuses une fois appliquées. Chaque régulation en engendre une nouvelle, qui ne vise qu’à colmater ses propres manquements.

La tentation est forte d’interrompre ici mon récit et de conclure que le problème vient des régulateurs, qui seraient soit idiots, soit mal intentionnés, voire les deux à la fois. C’est une voie qu’il ne serait pas satisfaisant d’emprunter, parce qu’il s’agirait au fond d’un aveu d’impuissance. Cela laisserait entendre que nos problèmes ne peuvent être résolus tant que stupidité et mauvaises intentions n’auront pas été écartés des lieux de pouvoirs, autant dire jamais. En ce qui me concerne, j’ai une théorie différente pour expliquer ce qui s’est passé.

Le problème, ce n’est pas que les législateurs n’entendent rien aux technologies de l’information, parce qu’il devrait être possible qu’un non spécialiste parvienne à rédiger une bonne loi. Parlementaires, membres du Congrès et autres hommes politiques sont élus pour représenter des circonscriptions et des citoyens, pas pour s’occuper de disciplines et de questions pointues. Nous n’avons pas un secrétaire d’État à la biochimie, ni un sénateur issu du magnifique État qu’est l’urbanisme. Pourtant, ces personnes, qui sont des experts de la politique et de l’élaboration des lois, et pas de disciplines techniques, réussissent malgré tout à établir des règles sensées. C’est parce que le gouvernement s’appuie sur l’heuristique : une approche empirique qui permet d’équilibrer les contributions d’experts apportant leur avis sur différents aspects d’une question.

Hélas, il existe un point sur lequel la technologie de l’information est supérieure à cette heuristique, et la bat même à plates coutures.

Il existe deux conditions importantes pour déterminer si une régulation est pertinente : d’abord, il faut savoir si elle sera efficace, et ensuite, si ses effets s’étendront au-delà de ce pour quoi elle a été conçue. Si je voulais que le Congrès, le Parlement, ou l’UE préparent une loi réglementant l’usage de la roue, il est peu probable que j’y parvienne. Si je me présentais en avançant que les braqueurs de banque s’enfuient toujours dans un véhicule à roues, et demandais si on peut y remédier, on me répondrait non. Pour la simple raison qu’on ne connaît aucun moyen de fabriquer une roue qui reste utilisable pour un usage licite, mais soit inutilisable pour les bandits. Il est évident pour tous que le bénéfice général des roues est si grand qu’il serait idiot de s’en passer, dans une tentative farfelue d’enrayer les braquages. Même si l’on connaissait une flambée de braquages – et même s’ils mettaient en péril la société –, personne ne songerait que s’en prendre aux roues puisse être un bon point de départ pour résoudre nos problèmes.

En revanche, si je me présentais dans cette même institution, déclarais posséder la preuve irréfutable que les kits mains-libres rendent les voitures dangereuses, et que je demandais une loi les interdisant, il n’est pas impossible que le régulateur prenne ma requête en compte et agisse sur la question.

On pourrait débattre de la légitimité de cette idée, du caractère sensé de mes preuves, mais très peu d’entre nous pourrions avancer que si l’on retire les kits main-libre, une voiture cesse d’être une voiture.

Nous sommes d’accord pour dire qu’une voiture reste une voiture si nous en retirons des accessoires. Les automobiles sont des engins à but précis, du moins si on les compare à la roue, et le seul apport d’un kit mains-libres, c’est une fonction supplémentaire ajoutée à une technologie déjà spécialisée.

De manière générale, cette approche empirique est efficace pour le législateur, mais elle devient caduque pour la question de l’ordinateur et du réseau généralistes – le PC et l’internet. Si l’on considère un logiciel comme une fonction, un ordinateur équipé d’un tableur a une fonction tableur, et un autre qui ferait tourner World of Warcraft aurait une fonction MMORPG. En appliquant la méthode heuristique, on pourrait penser qu’un ordinateur ne pouvant exécuter des feuilles de calcul ou des jeux ne constituerait pas davantage une atteinte à l’informatique qu’une interdiction des kits mains-libres ne le serait pour les voitures.

Et si l’on considère les protocoles et les sites web comme des fonctions du réseau, alors demander à modifier l’internet pour que BitTorrent n’y fonctionne plus ou que The Pirate Bay n’y apparaisse plus, cela n’est pas très différent de vouloir changer la tonalité du signal de ligne occupée, ou de déconnecter la pizzeria du coin du réseau téléphonique, et n’équivaut pas à une remise en question des principes fondamentaux de l’internet.

La méthode empirique fonctionne pour les voitures, les maisons, et tous les autres domaines majeurs des réglementations technologiques. Ne pas comprendre qu’elle n’est pas efficace pour l’internet, ce n’est pas être quelqu’un de mauvais, ni un ignare. C’est faire partie de la grande majorité de la population, pour qui le Turing-complet et le principe de bout-à-bout ne veulent rien dire.

Nos législateurs se lancent donc et votent allègrement ces lois, qui intègrent la réalité de notre univers technologique. Soudain, nous n’avons plus le droit de diffuser certaines séries de chiffres sur internet, il est interdit de publier certains programmes, et pour faire disparaître des fichiers licites du réseau, une simple accusation d’infraction au droit d’auteur suffit. Ces mesures échouent à atteindre l’objectif de la réglementation, car elles n’empêchent personne d‘enfreindre le copyright, mais de façon très superficielle, elles donnent l’impression que l’on fait respecter le droit d’auteur – elles satisfont au syllogisme de la sécurité : « Il faut prendre les mesures nécessaires, je prends des mesures, donc le nécessaire à été fait. » Résultat, au moindre échec, on peut prétendre que la réglementation ne va pas assez loin, au lieu de reconnaître qu’elle était inefficace depuis le début.

On retrouve ce genre de similarité superficielle et d’opposition sous-jacente dans d’autres domaines. Un de mes amis, autrefois cadre supérieur dans une grosse entreprise de biens de consommation courante, m’a raconté ce qui s’est passé lorsque les membres du service marketing avaient annoncé aux ingénieurs qu’ils avaient trouvé une idée formidable pour une lessive : désormais, ils allaient fabriquer une lessive grâce à laquelle les vêtements sortiraient plus neufs à chaque lavage !

Après avoir tenté sans succès d’expliquer au service marketing la loi de l’entropie, ils parvinrent à une autre solution : ils conçurent une lessive contenant des enzymes qui attaquaient les fibres éparses, celles-là mêmes qui donnent un aspect usé aux vêtements. À chaque machine, le linge paraissait plus neuf. Malheureusement, cela se produisait parce que le détergent digérait les habits. En l’utilisant, on condamnait littéralement le linge à se désagréger.

C’était évidemment l’inverse du but recherché. Au lieu de rajeunir les vêtements, on les vieillissait de façon artificielle à chaque passage en machine, et en tant qu’utilisateur, plus on appliquait cette « solution », plus on devait prendre des mesures radicales pour garder une garde-robe à jour. Au bout du compte, il fallait acheter des vêtements neufs parce que les anciens tombaient en lambeaux.

Aujourd’hui, certains services marketing déclarent : « Pas besoin d’ordinateurs, ce qu’il nous faut, ce sont des appareils électroménagers. Fabriquez-nous un ordinateur qui ne permet pas de tout faire, seulement de lancer un programme qui effectue une tâche spécialisée, comme lire de l’audio en streaming, transférer des paquets, ou jouer à des jeux Xbox, et surtout, il ne doit pas faire tourner un programme que nous n’avons pas autorisé et qui risquerait d’amoindrir nos profits. »

En surface, l’idée d’un programme ne servant qu’à une fonction spécialisée n’a rien de farfelu. Après tout, on peut installer un moteur électrique dans un lave-vaisselle, et installer un moteur dans un mixeur, et peu nous importe de savoir si l’on peut lancer un programme de lavage dans un mixeur. Mais ce n’est pas ce qui se produit lorsqu’on transforme un ordinateur en appareil électroménager. On ne fabrique pas directement un ordinateur qui ne fait tourner que l’application de l’« appareil ». On prend un ordinateur capable d’exécuter tous les programmes, puis, grâce à un ensemble de rootkits, d’espiogiciels et de codes de validation, on empêche l’utilisateur de savoir quels processus sont actifs, d’installer ses propres logiciels, et d’interrompre les processus qu’il ne désire pas. En d’autres termes, un appareil électroménager n’est pas un ordinateur réduit à sa plus simple expression, c’est un ordinateur entièrement fonctionnel bourré d’espiogiels.

Nul ne sait concevoir un ordinateur généraliste capable de faire fonctionner tous les programmes sauf ceux qui déplaisent au constructeur, sont interdits par la loi, ou font perdre de l’argent à une entreprise. Ce qui s’en approche le plus, c’est un ordinateur bardé d’espiogiciels, une machine sur laquelle des parties tierces décident de limitations sans que l’utilisateur en soit averti, ou malgré les objections du propriétaire de la machine. Les outils de gestion des droits numériques s’apparentent toujours à des logiciels malveillants.

À l’occasion d’un incident qui a fait couler de l’encre (un vrai cadeau pour ceux qui partage mon hypothèse), Sony a dissimulé des installeurs de rootkits sur six millions de CDs audio, lesquels exécutaient subrepticement des programmes qui surveillaient toute tentative de lire les fichiers sons du CD et les interrompaient. Les rootkits cachaient aussi leur existence en poussant le noyau de l’ordinateur à mentir sur les processus en activité et les fichiers présents sur le support. Et ce n’est pas le seul exemple de ce genre. La 3DS de Nintendo profite des mises à jour de son firmware pour procéder à un contrôle d’intégrité, et vérifier que l’ancien firmware n’a subi aucune altération. Au moindre signe qu’on a mofifié le programme, la console devient inutilisable.

Des défenseurs des droits de l’homme ont tiré le signal d’alarme concernant U-EFI, le nouveau programme d’amorçage des PC, qui restreint votre ordinateur de sorte qu’il n’exécute que les systèmes d’exploitation « homologués », faisant valoir que des régimes répressifs allaient vraisemblablement refuser l’homologation des systèmes d’exploitation qui ne permettraient pas des opérations de surveillance furtives.

En ce qui concerne le réseau, les tentatives de le modeler pour qu’il ne puisse servir à enfreindre le droit d’auteur rejoignent toujours les mesures de surveillance mises en place par des régimes répressifs. Prenons par exemple SOPA, la proposition de loi pour la lutte contre le piratage, qui interdit des outils inoffensifs tels que DNSSec (une suite de sécurité qui authentifie les informations envoyées par un nom de domaine) parce qu’il pourrait servir à contrecarrer des mesures de blocage de DNS. SOPA proscrit également Tor, un outil d’anonymat en ligne soutenu par le Naval Research Laboratory (NdT : laboratoire de recherche de la Marine des États-Unis), et utilisé par les dissidents dans les régimes totalitaires, parce qu’il permet de contourner des mesures de blocage d’adresse IP.

La Motion Picture Association of America (NdT : MPAA, l’organisme qui défend les intérêts de l’industrie cinématographique), un des partisans de SOPA, a même fait circuler un mémo qui citait des recherches avançant que SOPA pourrait fonctionner parce qu’elle s’appuie sur des mesures éprouvées en Syrie, en Chine et en Ouzbékistan. On y expliquait que, ces procédés étant efficaces dans ces pays, ils le seraient aussi aux États-Unis !

On pourrait avoir l’impression que SOPA (NdT : quand ce billet a été écrit, SOPA/PIPA n’avaient pas encore été ajournées suite au blackout) siffle la fin de partie au terme d’une longue lutte au sujet du copyright et d’internet, et l’on pourrait croire que si nous parvenons à faire rejeter SOPA, nous serons en bonne voie pour pérenniser la liberté des PC et des réseaux. Mais comme je l’ai précisé au début de cette intervention, le fond du sujet, ce n’est pas le copyright.

La bataille du copyright n’est que la version bêta d’une longue guerre qui va être menée contre l’informatique. L’industrie du divertissement n’est que le premier belligérant à prendre les armes, et dans l’ensemble, on peut penser qu’elle remporte de belles victoires. En effet, nous voici face à SOPA, qui est sur le point d’être votée, prête à briser les fondements de l’internet, le tout pour protéger les tubes du Top 50, les émission de télé-réalité et les films d’Ashton Kutcher.

En réalité, si la législation sur le copyright va aussi loin, c’est parce que les politiciens ne prennent pas la question au sérieux. C’est pourquoi, au Canada, les Parlements successifs n’ont eu de cesse de présenter des propositions de loi plus calamiteuses les unes que les autres, mais en contrepartie, ces mêmes Parlements n’ont jamais été capables de les voter. C’est pourquoi SOPA, une proposition de loi composée de stupidité à l’état pur et assemblée molécule par molécule pour former une sorte de « Stupidium 250 » que l’on ne trouve normalement que dans le noyau des jeunes étoiles, a vu son examen reporté au beau milieu des vacances de Noël – pour que les législateurs puissent participer à un débat national enflammé sur une question autrement importante, l’assurance chômage.

C’est pourquoi l’Organisation mondiale de la propriété intellectuelle se fait duper et promulgue des lois délirantes et d’une ignorance crasse ; parce que lorsqu’une nation envoie une mission à l’ONU de Genève, ce sont des experts en eau, pas en copyright. Des experts de la santé, pas du copyright. Des experts en agriculture, et toujours pas du copyright, parce que c’est loin d’être aussi important.

Le parlement canadien n’a pas soumis ces propositions de loi au vote parce que, parmi les inombrables sujets que le Canada doit traiter, les problèmes de copyright arrivent très loin derrière les urgences sanitaires dans les réserves indiennes, l’exploitation de la nappe pétrolière d’Alberta, l’intervention dans les frictions sectaires entre francophones et anglophones, la résolution des crises dues aux ressources de pêche, et des tas d’autres problèmes. À cause du caractère anodin du copyright, une chose est sûre : dès que d’autres secteurs de l’économie évinceront les inquiétudes au sujet de l’internet et du PC, on se rendra compte que la question du copyright n’était qu’une escarmouche, pas une guerre.

Pourquoi d’autres secteurs risquent-ils de s’en prendre aux ordinateurs comme c’est déjà le cas de l’industrie du divertissement ? Dans le monde d’aujourd’hui, tout est ordinateur. Nous n’avons plus de voitures, mais des ordinateurs qui roulent. Nous n’avons plus d’avions, mais des machines sous Solaris qui volent, agrémentées d’un tas de dispositifs de contrôle industriels. Une imprimante 3D n’est pas un appareil ménager, c’est un périphérique qui ne fonctionne qu’en étant connecté à un ordinateur. Une radio n’a plus rien du poste à galène d’antan, c’est un ordinateur généraliste qui utilise un logiciel. Le mécontentement que soulèvent les copies non autorisées du dernier best-seller à la mode sera insignifiant comparé aux appels aux armes que créera bientôt notre réalité tissée d’ordinateurs.

Prenons l’exemple de la radio. Jusqu’à présent, la réglementation concernant les radios se fondait sur l’idée que les propriétés d’une radio sont fixées à la fabrication, et qu’il est difficile de les modifier. Il ne suffit pas d’actionner un interrupteur sur votre babyphone pour capter d’autres signaux. Mais des radios logicielles puissantes peuvent servir d’interphone pour bébé, de répartiteur pour services d’urgence ou d’outil de contrôle aérien, simplement en chargeant et en exécutant un logiciel différent. C’est pourquoi la Federal Communications Commission (FCC) (NdT : Commission fédérales des communications) s’est intéressée à ce qui allait se produire lorsque les radios logicielles seraient disponibles, et a organisé une consultation pour savoir si elle devait imposer que toutes les radios logicielles soient enchâssées dans des machines d’« informatique de confiance ». En définitive, la question est de savoir si les PC devraient être verrouillés, de telle sorte que leurs programmes puissent être strictement contrôlés par des autorités centrales.

Là encore, ce n’est qu’un avant-goût de ce qui nous attend. C’est cette année seulement que sont apparues des limes open source pour transformer des fusils AR-15 en armes automatiques. C’est cette année qu’on a créé pour la première fois du matériel libre et financé collectivement destiné au séquençage génétique. Tandis que l’impression 3D donnera lieu à des tas de plaintes sans importance, des juges du Sud des États-Unis et des mollahs iraniens piqueront une crise quand des habitants de leur circonscription modèleront des sex-toys. Ce qu’il sera possible de fabriquer avec les imprimantes 3D, qu’il s’agisse de labos à méthemphétamine ou de couteaux céramiques, provoquera de véritables protestations.

Pas la peine d’être auteur de science-fiction pour comprendre que les régulateurs auront des suées à l’idée que l’on puisse modifier le firmware des voitures sans conducteur, limiter l’interopérabilité dans les systèmes de contrôle aérien, ou tout ce qui serait possible d’accomplir avec des assembleurs et séquenceurs moléculaires. Imaginez ce qui se passera le jour où Monsanto décrétera qu’il est primordial de s’assurer que les ordinateurs ne puissent exécuter des programmes grâce auxquels des périphériques produiraient des organismes modifiés qui, littéralement, concurrenceraient leur gagne-pain.

Qu’il s’agisse selon vous d’inquiétudes légitimes ou de peurs insensées, elles restent néanmoins la monnaie politique de lobbies et de groupes d’intérêt beaucoup plus puissants que Hollywood et l’industrie du divertissement. Tous finiront par formuler la même requête : « Fabriquez-nous donc un ordinateur grand public qui exécute tous les programmes, sauf ceux qui nous effraient et nous déplaisent. Fabriquez-nous un internet qui transmet des messages, sur tous les protocoles, d’un point à une autre, sauf si ça nous dérange. »

Parmi les programmes qui tourneront sur des ordinateurs grand public et leurs périphériques, cerains me ficheront les jetons à moi aussi. J’imagine donc sans mal que les partisans d’une limitation de ces ordinateurs trouveront une oreille réceptive. Mais comme cela s’est produit avec la guerre du copyright, interdire certaines instructions, certains protocoles et messages sera un moyen de prévention ou un remède tout aussi inefficace. Comme nous l’avons vu au cours de la guerre du copyright, toute tentative de contrôler les PC mènera à l’installation de rootkits, et toute tentative de contrôler l’internet débouchera sur la surveillance et la censure. Ces questions sont importantes, car depuis dix ans, nous envoyons nos meilleurs joueurs combattre ce que nous prenions pour le dernier boss du jeu, mais il s’avère que ce n’était qu’un boss secondaire. Les enjeux seront toujours plus importants.

Appartenant à la génération Walkman, je me suis résolu au fait que j’aurai besoin d’un appareil auditif pour mes vieux jours. Cela étant, ce ne sera pas un simple sonotone ; en réalité, ce sera un ordinateur. Quand je monterai dans ma voiture – un ordinateur dans lequel je place mon corps – équipé de mon aide auditive – un ordinateur que je place dans mon corps –, je veux donc être certain que ces technologies ne sont pas conçues pour me cacher des informations, ou m’empêcher de mettre fin à un processus qui œuvre contre mon intérêt.

L’année dernière, le secteur scolaire de Lower Merion, dans une banlieue aisée de Philadelphie, s’est trouvé au centre d’un scandale. On a découvert que les établissements distribuaient aux élèves des ordinateurs portables rootkités qui permettaient de procéder à une surveillance furtive et à distance, via la webcam et la connexion réseau. Les machines ont pris des milliers de photos des adolescents, chez eux et en cours, de jour ou de nuit, vêtus ou nus. Dans le même temps, la dernière génération de technologie de surveillance légale peut activer secrètement les caméras, les micros et les émetteurs-récepteurs GPS des PC, tablettes et appareils mobiles.

Nous n’avons pas encore perdu, mais si nous voulons que l’internet et les PC restent libres et ouverts, nous devons d’abord gagner la guerre du copyright. À l’avenir, afin de préserver notre liberté, nous devrons être en mesure de contrôler nos appareils et d’établir des réglementations sensées les concernant, d’examiner et d’interrompre les processus logiciels qu’ils exécutent, et enfin, de les maîtriser pour qu’ils restent d’honnêtes serviteurs de notre volonté, au lieu de devenir des traîtres et des espions à la solde de criminels, de bandits et de maniaques du contrôle.

Notes

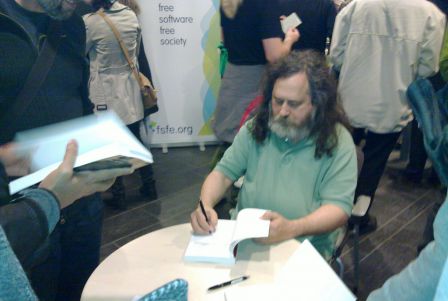

[1] Crédit photo : Francis Mariani (Creative Commons By-Nc-Nd)

« Où en sommes-nous ? Internet est aujourd’hui un champ de ruine déchiré par une guerre civile numérique où s’affrontent les milices privées de l’industrie du divertissement d’un côté et l’armée aux pieds nus des Anonymous de l’autre et dont les simples utilisateurs que nous sommes sont les victimes des balles perdues. » Pierre Mounier (modéré d’habitude, c’est vous dire si ça va mal)

Crédit : Simon Gee Giraudot (Creative Commons By-Sa)

« Nous avons tous intérêt à défendre l’Open Source contre les forces qui l’affaiblissent », nous affirme ici Matthew Butterick, juriste et passionné de typographie[1].

« Nous avons tous intérêt à défendre l’Open Source contre les forces qui l’affaiblissent », nous affirme ici Matthew Butterick, juriste et passionné de typographie[1].

Constatant que de nombreux projets se disent open source alors qu’ils n’en possèdent pas les caractéristiques, il nous propose ici de le définir en sept points, distinguant la réalité de ce qu’il appelle sa dilution.

Vous ne serez pas forcément d’accord, surtout si vous êtes plus « logiciel libre » (version canal historique Richard Stallman) que « Open Source ». Mais on devrait pouvoir en discuter sereinement dans les commentaires :)

Sept qualités essentielles à l’Open Source

Seven essential qualities of open source

Matthew Butterick - Janvier 2012 - TypographyForLawyers.com

(Traduction Framalang : Goofy, OranginaRouge, antistress)

Les citations tronquées déforment les propos. Beaucoup connaissent la fameuse citation de Stewart Brand selon laquelle « l’information veut être gratuite » (NdT : « information wants to be free. »). Cette phrase, prise isolément, est souvent citée à l’appui de thèses selon lesquelles toute contrainte sur l’information numérique est futile ou immorale.

Mais peu ont entendu la deuxième partie du propos, rarement citée, qui prend le contrepied de la première partie : « l’information veut être hautement valorisée » (NdT : « information wants to be expensive. »). Lorsque l’on reconstitue le propos dans son entier, il apparait que Brand veut illustrer la tension centrale de l’économie de l’information. Lorsque le propos est tronqué, sa signification en est changée.

Les citations tronquées ont aussi déformé le sens de « Open Source ». Au fur et à mesure que le monde de l’Open Source prenait de l’ampleur, il a attiré davantage de participants, depuis les programmeurs individuels jusqu’aux grandes entreprises. C’était prévisible. Tous ces participants ne sont pas d’accord sur le sens donné à l’Open Source. Ça aussi c’était prévisible. Certains participants influents ont tenté de diluer l’idée de l’Open Source, usant d’un raccourci réducteur pour décrire une démarche méthodique. Ça aussi, on pouvait s’y attendre.

Mais même si cela était à prévoir, il est toujours payant de combattre cette dilution. Sur le long terme, cela est néfaste à l’Open Source. Et pas seulement pour des raisons éthiques ou morales mais aussi pour des raisons pratiques et de viabilité. Si on laisse l’Open Source se diluer en acceptant de revoir à la baisse les attentes, ceux d’entre nous qui jouissent des avantages de l’Open Source seront perdants à terme. De la même façon, ceux qui contribuent à des projets pseudo-Open Source risquent de dépenser leur énergie au profit de causes douteuses. C’est pourquoi nous avons tous intérêt à défendre l’Open Source contre les forces qui l’affaiblissent.

Dans le même esprit, voici sept qualités que je considère comme essentielles pour définir l’identité de l’Open Source, par opposition aux formes diluées que revêt généralement ce mouvement. L’objectif de cet exercice n’est pas d’offrir une caractérisation univoque de l’Open Source. Ce serait à la fois présomptueux et impossible. L’Open Source est hétérogène par essence, comme tout ce qui apparaît sur la place publique.

Pourtant, le fait que nous puissions parler de l’Open Source en général signifie qu’il doit y avoir des caractéristiques irréductibles. Des gens raisonnables, par exemple, peuvent avoir des conceptions différentes de l’art. Mais qui irait contester la qualité de Mona Lisa ? De la même façon, s’il n’est pas raisonnable de parler de l’Open Source comme d’un bloc monolithique, il est tout aussi déraisonnable de prétendre que c’est un concept complètement subjectif. L’Open Source doit pouvoir être défini sinon le terme lui-même n’a pas de sens.

Pourquoi rédiger un essai sur l’Open Source sur un site Web traitant de typographie ? Premièrement parce que les outils open source prennent une part de plus en plus importante dans la conception des polices (citons par exemple RoboFab). Deuxièmement parce que des polices soi-disant open source sont en train d’être produites à une cadence accélérée. Troisièmement parce que l’approche utilisée pour l’Open Source est de plus en plus appliquée aux projets issus des domaines du design ou du droit. Quatrièmement parce que je m’intéresse personnellement de longue date à l’Open Source, ayant par exemple travaillé pour Red Hat (ajoutons que ce site tourne avec WordPress, un moteur de blog open source).

Qualité essentielle n°1

- Dilution : L’Open Source émane d’un esprit de liberté et de coopération.

- Réalité : L’Open Source émane d’un esprit de compétition capitaliste.

L’Open Source, en tant que méthode de conception d’un logiciel, permet l’émergence de produits compétitifs sans les besoins en capitaux et main-d’œuvre inhérents aux méthodes traditionnelles de développement des logiciels propriétaires. La plupart des projets open source à succès sont conçus comme des substituts de logiciels propriétaires à succès. Il n’y a pas de coïncidence. La demande en logiciels propriétaires est aussi ce qui créée la demande pour des alternatives open source.

De plus, le succès d’un projet open source dépend de sa capacité à rivaliser avec l’alternative propriétaire. Le temps, c’est de l’argent. Les logiciels open source qui ne remplissent pas leur office ne font pas des bonnes affaires au final. Bien que certains choisiront le logiciel open source pour des raisons purement politiques, les clients rationnels se prononceront sur la base d’un bilan coûts/avantages.

Qualité essentielle n°2

- Dilution : Les développeurs de logiciels open source travaillent gratuitement.

- Réalité : Les développeurs de logiciels open source sont rémunérés.

Personne ne travaille sur des projets open source gratuitement. Peut-être un petit groupe de développeurs contribue t-il à des projets open source pour se distraire au lieu de collectionner des timbres par exemple. Il s’agit là d’une minorité. La plupart du travail open source est réalisé par des développeurs professionnels qui sont rémunérés à un tarif professionnel.

C’est forcément vrai, et ce pour deux raisons.

Premièrement, les développeurs ne sont pas altruistes. Comme n’importe qui d’autre sur le marché du travail, ce sont des acteurs rationnels, et bien payés avec ça. Il n’y a aucune raison pour que ces développeurs se consacrent au développement de logiciels open source moyennant un salaire de misère alors qu’il existe plein d’entreprises qui accepteraient de les payer pour le même travail.

Deuxièmement, ainsi que nous l’avons déjà mentionné, le logiciel open source ne peut réussir que s’il a les moyens de rivaliser avec les alternatives propriétaires. Et il ne peut rivaliser avec les logiciels propriétaires que s’il parvient à attirer des développeurs de même niveau. Et la seule façon d’attirer ces développeurs est de les rémunérer au prix du marché. De la même façon qu’il n’y a pas de déjeuner gratuit, il n’y a pas d’avantage de logiciel gratuit.

Qualité essentielle n°3

- Dilution : L’Open Source rend les choses gratuites.

- Réalité : L’Open Source redéfinit ce qui a de la valeur.

Les développeurs de logiciels open source ne travaillent pas gratuitement, mais il existe un corollaire à cette affirmation : les projets open source bénéficient, pour une valeur équivalente, à ceux qui financent ce travail de développement — habituellement les employeurs des développeurs.

Si vous croyez que les entreprises de technologies sont des acteurs rationnels de l’économie, vous avez certainement raison. Une société investira son capital dans les activités les plus rentables qu’elle pourra trouver. Si une entreprise finance des projets open source, elle en espère un retour sur investissement supérieur aux autres options.

Alors que les défenseurs des logiciels libres ou open source tentent parfois d’en illustrer l’idée avec ces comparaisons : libre comme dans « entrée libre » ou comme dans « expression libre » (NdT : « free as in beer » et « free as in speech », deux images souvent utilisées en anglais pour distinguer les deux sens du mot « free », respectivement gratuit et libre), un ingénieur de Red Hat me l’a un jour plus exactement décrit de cette façon : « gratuit comme un chiot ». Certes vous ne payez pas les logiciels open source. Mais vous ne bénéficiez pas des avantages habituels des logiciels propriétaires : facilité d’installation, support d’utilisation, documentation, etc. Soit vous payez avec votre temps, soit vous payez quelqu’un pour ces services. Le résultat est que le coût des services liés au logiciel est déplacé à l’extérieur du logiciel lui-même au lieu d’être inclus dans son prix. Mais ce coût est seulement déplacé, et non supprimé.

Qualité essentielle n°4

- Dilution : Il n’y a pas de barrière pour participer à l’Open Source.

- Réalité : L’Open Source s’appuie sur la méritocratie.

L’Open Source ne pourrait pas fonctionner sans un filtrage méritocratique. Ce principe découle de l’idée que l’Open Source est une méthode pour créer des produits compétitifs. Pour obtenir des résultats de haute qualité, les projets open source doivent mettre l’accent sur les contributions de haute qualité, et rejeter le reste. Les projets open source sont ouverts à tous dans le sens où n’importe qui peut suggérer des changements dans le code source. Mais ces changements peuvent toujours être rejetés ou annulés.

L’idée de l’Open Source est mal employée quand elle est appliquée à des projets qui n’ont pas ce filtrage méritocratique et auxquels n’importe qui peut contribuer. Ces projets sont plutôt décrit comme du « partage de fichiers ». Ce qui distingue la méthode open source est son appui sur une communauté de développeurs pour trouver les meilleures idées. Cela signifie donc que la plupart des idées sont rejetées.

Qualité essentielle n°5

- Dilution : L’Open Source est démocratique.

- Réalité : L’Open Source s’appuie sur des dictateurs bienveillants.

Les projets open source sont menés par des développeurs qui sont parfois appelés des « dictateurs bienveillants ». Habituellement il s’agit de ceux qui ont démarré le projet et qui sont considérés comme détenant la vision de l’avenir du projet.

Ils ne sont pas élus mais, d’un autre côté, il ne sont autorisés à rester au pouvoir que tant que les autres participants y consentent. C’est le principe de l’Open Source : n’importe qui peut récupérer le code source et l’utiliser pour démarrer un nouveau projet (cette pratique a pour nom le « forking »).

Cela arrive rarement. En fin de compte, les participants à un projet open source ont davantage à gagner à conserver le projet intact sous la direction d’un dictateur bienveillant plutôt que le fragmenter en de multiples projets. (notons ici encore l’influence des incitations rationnelles). De même, le dictateur a intérêt à rester bienveillant puisque le projet pourrait à tout moment se dérober sous ses pieds.

Qualité essentielle n°6

- Dilution : Un projet open source peut n’avoir qu’un développeur.

- Réalité : Un projet open source nécessite plusieurs développeurs.

Cette exigence découle de l’idée que l’Open Source est une méritocratie. Il ne peut y avoir de filtrage méritocratique si toutes les contributions viennent d’une seule personne. Parfois certains publieront leur projet personnel et annonceront « Hé, c’est maintenant open source ».

Cela ne le rend pas pour autant open source, pas plus qu’acheter un pack de bières et des chips suffisent à faire une soirée. Vous aurez toujours besoin d’invités. De même pour créer une pression méritocratique, les projets open source ont besoin de plusieurs développeurs (pour créer une émulsion d’idées) et d’un dictateur éclairé (pour choisir parmi ces idées). Sans cette pression, on a affaire à du partage de fichiers, pas de l’Open Source.

Qualité essentielle n°7

- Dilution : Un projet logiciel peut devenir open source à tout moment.

- Réalité : L’Open Source est inscrit dans l’ADN du projet ou ne l’est pas.

Comme l’Open Source rencontre un succès grandissant, de plus en plus de projets de logiciels propriétaires ont été « convertis » en logiciels open source. Cela revient à greffer des ailes à un éléphant dans l’espoir qu’il volera.

L’Open Source est une manière de produire des logiciels (entre autres). Cela inclut certaines valeurs et en exclut d’autres. Cela n’est ni intrinsèquement meilleur que le développement de logiciels propriétaires ni applicable à tous les projets. Mais la décision de développer un projet open source n’a du sens qu’au démarrage du projet. De cette manière, le dirigeant, la communauté des développeurs et le code pourront évoluer autour des ces principes.

Un projet propriétaire démarre avec des principes radicalement différents et évolue autour de ces principes. Et il ne pourra pas devenir plus tard un projet open source, pas plus qu’un éléphant ne peut devenir un aigle. Néanmoins, ceux qui convertissent des projets propriétaires en projets open source suggèrent le plus souvent que cela offre le meilleur des deux mondes : une manière de partager les bénéfices d’un développement propriétaire avec une communauté open source.

Mais cela offre presque toujours le pire des deux mondes : l’ouverture des sources n’est qu’une manière cynique d’exporter les problèmes d’un projet propriétaire. Malheureusement c’est ce qui se produit la plupart du temps car des projets propriétaires qui fonctionnent n’ont rien à gagner à devenir open source. Les développeurs n’adoptent pas votre technologie propriétaire ? Ramenez son prix à zéro et renommez le « Open Source ». Votre logiciel propriétaire est rempli de mystérieux bogues insolubles ? Rendez le « Open Source » et peut-être que quelqu’un d’autre résoudra ces problèmes. Votre technologie est sur le point de devenir obsolète car vous avez été trop lent à la mettre à jour ? Peut-être que la rendre open source allongera sa durée de vie. Les entreprises refourguent leurs logiciels à la communauté open source quand elles n’ont plus rien à perdre.

Cependant cette technique n’a jamais payé. Les projets open source qui fonctionnent ont appliqué cette méthodologie très tôt et s’y sont tenu. Le simple engagement en faveur de l’open source n’est pas un gage de succès bien qu’il soit nécessaire.

La plupart de mes explications ci-dessus ont été formulées en termes de développement logiciel. Mais ce message a une portée qui va au delà du simple logiciel. Je pense que « l’Open Source » vient du monde du logiciel, et restera certainement plutôt adapté à ce type de projet, mais il n’y a aucune raison à ce qu’il ne convienne pas à d’autres types de projets. C’est déjà ce qui se passe.

La principale difficulté est d’appliquer de façon méticuleuse et réfléchie le modèle open source. Au fur et à mesure que l’Open Source s’étend et s’éloigne de ses racines traditionnelles, il va devoir faire face à un risque grandissant de dilution. Encore une fois, je ne prêche pas une définition canonique de l’Open Source. Peut-être que le meilleur que nous pouvons espérer est que ceux qui souhaitent qualifier leur projet d’open source apprendront d’eux-mêmes les caractéristiques qui font le succès de ce type de projet. Si vous n’aimez pas mon résumé de ces qualités essentielles, alors apprenez-en suffisamment à propos de l’Open Source pour venir avec le vôtre. Et ne vous sentez pas obligé, ne prenez pas cela comme un devoir à la maison — faites cela dans votre propre intérêt.

Ça ne peut pas faire de mal de se pencher sur les autres projets open source pour comprendre comment ils ont réussi. Une fois cet examen réalisé, si vous voulez modifier les grands principes pour votre propre projet, allez-y ! Je ne m’en plaindrai pas.

Et accordez-moi une faveur : n’appelez pas cela Open Source.

La trappe Google commencerait-elle à doucement mais sûrement se refermer sur ses utilisateurs, mettant du plomb dans l’aile à son fameux slogan « Don’t be evil » ?

Deux récents changements le laissent en effet à penser. Tout d’abord une modification en profondeur de l’affichage des résultats du moteur de recherche au profit de son propre réseau social Google+ et au détriment de la neutralité et des petits camarades Facebook, Twitter & Co (qui ont réagit comme il se doit).

Et puis donc, voir ci-dessous, cette toute nouvelle mise à jour de sa politique de confidentialité qui vous impose le regroupement de toutes les données personnelles de vos différents comptes Google (Gmail, YouTube, Calendar, Recherche…). On pourra voir (avec le recul nécessaire) cette vidéo made by Google pour comprendre de suite de quoi il s’agit[1] ou encore cette dépêche AFP déjà plus objective.

Officiellement, du côté de chez Google, on ne parle que d’expérience utilisateur enrichie. Il ne s’agit en effet que d’améliorer la pertinence des résultats (et des encarts publicitaires proposés). D’ailleurs c’est titré « Des règles de confidentialité unifiées pour une expérience Google unique » sur leur site.

Mais si on y réfléchit bien, avec un compte Gmail et un smartphone Android à la géolocalisation activée (ce qui est fréquent même chez les librisites), Google est désormais capable de tout savoir de vous, d’autant que Google+ vous a encouragé à vous inscrire sous votre propre nom !

Bien sûr, Google n’est ni un service public, ni une organisation philanthropique, et il en va de notre propre responsabilité d’accepter des contrats que Google peut modifier quand bon lui semble lorsque nous avons décidé de nous inscrire chez eux.

Mais quand on y réfléchit bien Big Brother n’est vraiment plus très loin, et le diable non plus…

Google a rompu le pacte : son engagement à « ne pas faire de mal »

Google’s Broken Promise: The End of “Don’t Be Evil”

Mat Honan - 24 janvier 2012 - Gizmodo

(Traduction Framalang : Cheval_boiteux, OranginaRouge, Goofy)

Changement radical de sa politique de confidentialité, Google a annoncé aujourd’hui qu’il allait commencer à pister ses utilisateurs à travers tous ses services (Gmail, Search, YouTube et d’autres encore) et partager les données des activités de l’utilisateur entre les différents services. Et voilà le Google pour lequel nous nous sommes inscrits.

Le changement a été annoncé aujourd’hui dans un billet du blog officiel et général de la société, et va prendre effet le 1er mars prochain. Après cette date, si vous avez un compte Google pour utiliser un de ses services, l’entreprise pourra utiliser ces informations sur les autres services. Comme Google le dit :

Notre nouvelle politique de confidentialité sera claire, si vous la signez, nous pourrions combiner les informations que vous avez fournies à l’un de nos services avec les informations des autres services. Pour faire plus court, nous vous traiterons comme un seul utilisateur sur tous nous produits, ce qui rendra votre expérience de Google plus simple et plus intuitive.

On le voyait venir de loin. La politique de confidentialité de Google est passée de données cloisonnées à des données partagées entres les différents services. Cela vous amène irrémédiablement à vous désanonymiser, tout d’abord en requérant votre vrai nom sur Google+ par exemple puis ensuite en liant votre compte Google+ à votre compte Gmail. Mais voici venir un tout nouveau degré de partage. Et étant donné l’accueil désastreux dû aux problèmes de confidentialité posés par Google+, il est particulièrement troublant de voir Google prendre des mesures qui entament davantage encore la confidentialité des utilisateurs.

Cela signifie pour vous que toutes les données provenant de ce que vous recherchez, des emails que vous écrivez, des endroits que vous admirez sur Google Maps, des vidéos que vous regardez sur YouTube, des discussions que vous avez sur Google+, tout sera rassemblé au même endroit. Cela touchera en particulier les utilisateurs d’Android par leur localisation en temps réel (s’ils ont activé Latitude), les données de Google Wallet, et bien d’autres données qui seront récoltées. Et le plus surprenant est que si vous êtes inscrits à Google+, l’entreprise connaît même votre vrai nom, ce qui fournit une nouvelle barrière à l’utilisation d’un pseudonyme (bien qu’il ne soit pas explicitement requis des utilisateurs qu’ils s’inscrivent sous leur vrai nom).

L’intégralité des données de l’historique seront dorénavant recoupées. Bien que l’intérêt affiché soit de fournir aux utilisateurs une meilleure expérience (comprendre des résultats encore plus appropriés), cela permettra vraisemblablement à Google de cibler encore mieux ses publicités. (Au passage, c’est l’occasion ou jamais de vous familiariser avec les préférences de Google Ads).

Pourquoi disons-nous que ce changement est mauvais ? Parce que Google vient de changer les règles qu’il avait lui-même fixées.

Google a fondé sa réputation, et son chiffre d’affaires à plusieurs milliards de dollars, sur l’engagement de principe « ne rien faire de mal ». Cela fut largement interprété comme un moyen pour Google de toujours placer ses utilisateurs en premier, une interprétation qu’elle a cultivée et encouragée. Google a donc construit cette entreprise très lucrative sur la réputation du respect de l’utilisateur. Elle a investi des milliards de dollars dans le but de nous donner à tous l’impression d’être sous son agréable dôme protecteur. Et maintenant qu’elle tire les marrons du feu, tout s’écroule. Cela nous donne quelques semaines pour retirer nos données, en utilisant son service de libération des données, mais si vous désirez utiliser les services de Google, vous devrez vous plier à ses règles.

Les principes de Google mentionnent explicitement l’intention de gagner de l’argent sans faire rien de mauvais. Et l’entreprise est très claire en classant ses appels à la publicité dans la section « le mal ». Mais; alors qu’elle met l’accent sur la nécessité pour les pubs d’être pertinentes, sans ambiguïtés et « non-intrusives », ce qu’elle semble avoir oublié c’est le simple respect de la confidentialité des données de ses utilisateurs, et des pratiques qu’elle avait établies.

Parmi ses principes de confidentialité, le point numéro 4 indique :

Les préoccupations en matière de confidentialité ne sont pas les mêmes pour tout le monde. Afin de répondre aux attentes particulières de chacun des utilisateurs, Google s’efforce de leur proposer des choix significatifs et détaillés concernant l’utilisation de leurs informations personnelles. Nous pensons que les informations personnelles des utilisateurs ne doivent pas être « prises en otage ». Dans cette optique, nous nous engageons à concevoir des produits qui permettent aux utilisateurs d’exporter leurs informations personnelles vers d’autres services. Sachez que nous ne vendons pas les informations personnelles de nos utilisateurs.

Voilà qui franchit le Rubicon. C’est la fin du contrôle détaillé sur nos données, et cela signifie qu’à compter du 1er mars votre nom, votre visage, votre numéro de téléphone seront explicitement associés à des choses que vous pouviez jusqu’à présent faire sous le couvert d’un relatif anonymat. Si vous utilisez les services de Google, vous devrez accepter sa nouvelle politique de confidentialité. Et pourtant s’il y a une préoccupation qui surpasse les autres c’est bien que je ne voudrais surtout pas que Google puisse associer deux éléments d’information me concernant.

Et le pire, c’est le retournement de situation par rapport à une précédente politique. Comme l’a indiqué Google en 2009 sur son blog :

Précédemment, nous offrions la recherche personnalisée pour les utilisateurs inscrits, et uniquement quand ils avaient activé l’historique de navigation dans leur compte Google. Ce que nous faisons aujourd’hui consiste à étendre la recherche personnalisée afin de la rendre également accessible aux utilisateurs n’ayant pas de compte Google. Cette nouvelle fonctionnalité nous permet de baser la personnalisation de vos résultats de recherches sur 180 jours d’activités en la liant à un cookie anonyme dans votre navigateur. Cela est complétement séparé de votre compte Google et de votre historique de recherche (qui sont uniquement disponibles pour des utilisateurs enregistrés). Vous saurez quand nous personnalisons les résultats car un lien « Vue personnalisée » apparaîtra en haut à droite de la page des résultats. En cliquant sur ce lien, vous pourrez voir comment nous avons personnalisé vos recherches et vous pourrez également désactiver cette personnalisation.

Ces changements sont survenus peu après que Google a complètement repensé ses résultats de recherche pour inclure les réseaux sociaux, dans un service intitulé « Search plus Your World » (NdT : Recherche augmentée dans votre univers). Bien que cette nouvelle stratégie ait suscité une vague de violentes critiques sur le Web entier, elle laisse au moins à l’utilisateur la possibilité de ne pas y prendre part.

Notes

[1] Crédit photo : Steve Rhodes (Creative Commons By-Nc-Nd)

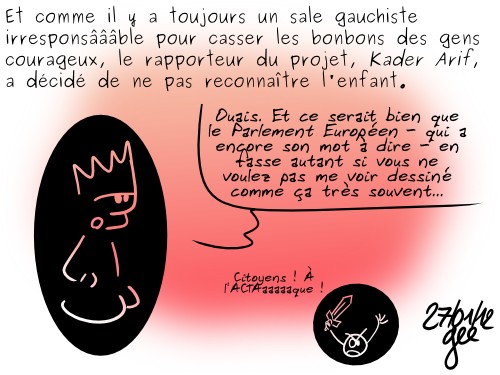

Les utilisateurs de MegaUpload qui stockaient, partageaient et s’échangeaient des fichiers tout à fait légaux sont les dindons de la farce.

C’est ce que nous rappelle coup sur coup deux articles de Numerama : MegaUpload : des voix s’élèvent pour récupérer les fichiers légaux et MegaUpload : peu d’espoir pour les fichiers légaux[1].

Peu de chance de les récupérer ? C’est sans compter sur l’énergique Pirates de Catalunya (Parti Pirate Catalan) qui en appelle avec d’autres à se regrouper pour étudier la faisabilité d’une procédure.

Plainte commune des personnes affectées par la fermeture de Megaupload

Joint complaint of those affected by the closure of Megaupload service

Pirates de Catalunya - Janvier 2012

(Traduction Framalang/Twitter : HgO, Chaman, AlBahtaar, FredB)

Des millions d’utilisateurs légitimes se sont subitement retrouvés lésés par la tentative des autorités américaines d’imposer leur propre loi à travers le monde.

Le FBI a causé des dommages incalculables, dépassant de loin les prétendues pertes déclarées par les lobbies des ayants droit, au cours d’une vaine tentative d’empêcher l’accès au contenu multimédia hébergé sur Megaupload, dont certains ont été déclarés comme violant la loi américaine sur le droit d’auteur. Parce que ce contenu illégal se trouvera bien vite accessible sur Internet via d’autres services. Cette action ne montre pas seulement la futilité de telles mesures mais rappelle aussi que ces fichiers ne sont pas forcément illégaux, ou n’ont jamais été prouvés comme tels, dans n’importe quel pays, y compris aux États-Unis.

En revanche, en fermant le service, ils ont entravé l’accès à des millions de fichiers appartenant à des individus comme à des organisations causant ainsi des pertes personnelles, économiques et d’image potentiellement importantes pour un grand nombre de personnes. De plus, le Parti Pirate souligne que les articles 197 et 198 du Code Pénal espagnol ont probablement été violés en s’appropriant ainsi des données personnelles à tort.

Les larges dégâts causés par la fermeture soudaine de Megaupload sont injustifiés et complètement disproportionnés par rapport à la cible visée. C’est pour cela que le Parti Pirate Catalan, en collaboration avec le Parti Pirate International et d’autres Partis Pirates (incluant le Parti Pirate du Royaume-Uni), a débuté une enquête sur de potentielles failles législatives et soutienda les poursuites en justice contre les autorités américaines dans autant de pays que possible, afin que justice soit rendue.

Afin de faire plainte commune, une plateforme a été créée où toute personne ou organisation ayant été affectée par cette fermeture peut exprimer son intérêt, indépendamment du type de compte qu’elle avait sur Megaupload.

Cette initiative est un point de départ pour aider les utilisateurs légitimes d’Internet à se défendre contre les abus légaux promus par ceux qui souhaitent cadenasser les ressources culturelles au profit de leurs propres gains financiers.

Quelles que soient les opinions quant à la légalité ou la morale des personnes exploitant Megaupload, des actions telles que la fermeture de ce service ont infligé des dommages énormes aux utilisateurs en règle de ce site et sont des violations de leurs droits inacceptables et disproportionnées.

Pour toutes les raisons énoncées, nous vous demandons de nous rejoindre et de nous soutenir en propageant cet appel, car des actes tels que ceux-ci ne doivent pas et ne devraient pas être pardonnés.

Notes

[1] Crédit photo : Ricard Clupés (Creative Commons By-Nc-Sa)

On peut se féliciter du spectaculaire succès de la récente action contre les lois SOPA et PIPA mais quelques part il était déjà trop tard. Il ne restait plus qu’à résister, ce qui fut fait et bien fait jusqu’à… la prochaine attaque !

Engagez-vous, comme dirait l’autre, pour casser ce cercle vicieux qui nous voit être trop souvent sur la défensive[1], pour proposer et mettre en place d’urgentes et salutaires alternatives.

Un article qui fait écho à une autre de nos traductions : Le jour d’après le blackout SOPA ou ce que j’aurais aimé entendre de Wikipédia & Co.

Il est temps de passer à l’offensive pour défendre la liberté d’expression

It’s Time To Go On The Offensive For Freedom Of Speech

Rick Falkvinge - 22 janvier 2011 - TorrentFreak - CC BY-SA

(Traduction Framalang/Twitter : skhaen, vinci, toto, e-Jim, quota)

L’action collective de la semaine dernière contre les lois PIPA et SOPA aux États-Unis était fabuleuse et sans précédent. Mais n’avez-vous pas remarqué que nous étions toujours sur la défensive ? Nous ne pourrons pas gagner ni même conserver notre liberté d’expression en continuant ainsi.

L’industrie du copyright est tenace et utilise, avec une grande efficacité il faut l’avouer, pour faire voter des lois, la technique dite du « Papa, je veux un poney ». Ils y reviennent sans cesse. Conséquence de cela, nous assistons à une érosion sans fin de nos droits civiques, et à l’enracinement du fait que cette industrie doive profiter de nos impôts.

La tactique dite de « Papa, je veux un poney » fonctionne à peu près comme suit :

— La petite fille : Papa, Je veux un poney ! veux un poney ! je veux veux veux un poney !

— Le père : Hum, non, hum, hum, non, pourquoi pas plutôt un chien ?

— La petite fille : Non non NON ! Je veux un poney ! un PONEY ! … Heu, bon, un chien ? d’accord !

À ce moment là le père pense : « pfiou, je l’ai échappé belle ». Et la petite fille pense « wow, ce fut le chien le plus facile à avoir que j’ai jamais eu ». C’est la tactique « Papa, je veux un poney ».

Nous avons vu cette tactique à l’oeuvre avec le DMCA (NdT: Digital Millennium Copyright Act) aux États-Unis, lequel a largement restreint nos droits sur notre propriété privée, ainsi qu’avec son pendant Européen, la directive InfoSoc (NdT: Directive 2001/29/CE du Parlement européen et du Conseil du 22 mai 2001 sur l’harmonisation de certains aspects du droit d’auteur et des droits voisins dans la société de l’information). Nous pouvons la voir en ce moment même avec ACTA qui, à nouveau, est une illustration de cette attitude « on peut retirer le plus choquant, le plus répugnant. », tout en laissant passer d’autres éléments qui n’en constituent pas moins un énorme pas en arrière en matière de droits de l’Homme. Nous l’avons vu également avec le Directive sur la Conservation des Données.

À chaque fois, nous nous défendons et réussissons à faire supprimer les pires morceaux, en brûlant à chaque fois davantage nos réserves d’activistes. Puis il y a une nouvelle attaque trois ans plus tard. Ajoutons qu’à chaque fois que nous nous battons contre un de ces maux, une dizaines d’autres passent discrètement en douce dans les coulisses du pouvoir.

Le truc, c’est que tant que nous nous bornerons à défendre nos droits, nous aurons en permanence un coup de retard, et nous perdrons toujours. L’industrie du copyright a l’initiative, et le mieux que nous puissions faire est de résorber le retard que nous avons, ou de limiter les dégats déjà provoqués. Cela n’est pas suffisant.

Et il y a pire. L’industrie du copyright a également obtenu le droit de percevoir des taxes sur le commerce de produits sans liens directs avec le droit d’auteur, notamment les médias vierges (NdT : cf la taxe sur la copie privée) mais également des objets ayant à priori peu à voir avec la copie d’œuvres telles que les consoles de jeux, parce qu’elles peuvent théoriquement être utilisées comme support pour copier des ressources de manière tout à fait légale. Vous comprenez ça, vous ? Copier ainsi ne viole pas le monople instauré par le copyight, mais l’industrie du copyright reçoit quand même cette compensation.

Reprenons.

Le monopole du copyright, bien qu’étant très étendu, ne recouvre pas tout acte de copie imaginable. Il y a beaucoup de manières de copier qui sont parfaitement légales et non couvertes par ce monopole. Mais dans le sens du copyright tel que l’entendent les industriels, il ont demandé - et obtenu - une compensation concernant les domaines où le monopole du copyright ne s’étend pas. Une compensation de la poche du contribuable, versée à une industrie privée. Pour n’avoir pas de monopole. Vous y croyez ?

Dans ce schéma de compensation, ils collectent des sommes d’argent faramineuses chaque année sans avoir besoin de faire quoi que ce soit. Beaucoup de cet argent est directement reversé dans la guerre contre nos droits civiques, et dans toujours plus de lobbying pour d’obtenir encore plus d’argent du contribuable, avec de nouveaux schémas de type : « Papa, je veux un poney ». Pour nous, c’est un cercle vicieux. N’importe qui, connaissant un peu les différents moyens de motiver quelqu’un, sait que la pire manière d’optimiser la production consiste à donner de l’argent à une industrie sans tenir compte de ce qu’ils sont en train de faire avec cet argent, que ce soit en bien, en mal, ou en rien du tout.

Donc, pour résumer, l’industrie du copyright s’est mise elle-même dans une position où elle gagne des sommes incroyables en ne faisant absolument rien, et utilise cet argent pour acheter des lois qui leur donneront encore plus d’argent, tout en réduisant notre liberté d’expression. Ce n’est pas seulement inacceptable. C’est répugnant.

C’est une surprise pour personne, je pense depuis longtemps que le monopole du copyright est dangereux (ou au moins inutile) dans son ensemble, et que la créativité, le business et les libertés civiles s’en porterait bien mieux s’il n’existait pas. Pour avoir étudié le sujet pendant 6 ans d’affilée, je découvre toujours plus d’indicateurs qui me confortent dans ma position.

Mais je suis également assez pragmatique pour comprendre que si vous visez la lune et insistez pour ne pas avoir d’étape intermédiaire entre le départ et l’arrivée, non seulement vous n’arriverez jamais à l’atteindre, mais vous risquez en plus de ne pas faire un seul pas en avant. S’engager ne serait-ce que partiellement vers la lune peut déjà vous apporter satisfaction. 99% des problèmes avec le copyright d’aujourd’hui peuvent être résolus avec une réforme réaliste et raisonnable.

Lorsque l’enjeu est d’envergure, on ne peut pas changer toutes les règles du jeu en un jour. Donc visons à établir une proposition équilibrée et raisonnable qui restaure nos libertés civiles tout en conservant certains aspects des investissements qui incitent au développement de la culture.

J’emprunte ce plan au groupe des Verts du Parlement Européen (et plus précisément à la délégation du Parti Pirate qui l’abrite). Essayons de faire passer cette nouvelle législation en Europe, aux USA, en Australie, et partout où l’on pourra :

- Il faut impérativement mettre au clair que le monopole du copyright ne peut s’étendre à ce qu’une personne ordinaire peut faire avec un équipement ordinaire, chez lui, et sur son temps libre ; ce monopole doit ne réguler que l’activité commerciale, dans le but de faire du profit. En particulier, le partage de fichiers est toujours légal.

- Échantillons gratuits. Il doit exister des exceptions qui rendent légale la création de remixes et de mashups. Les droits de citation tels qu’ils existent pour le texte, doivent être étendus aux sons et aux vidéos.

- Les outils de restriction des droits numériques (DRM) devraient être rendus illégaux, car c’est une escroquerie qui nie les droits des consommateurs et des citoyens, à défaut il doit au moins être possible de les contourner légalement.

- Le monopole du copyright commercial basique est ramené à cinq ans à dater de la publication, extensible à vingt ans si l’oeuvre a été enregistrée dans une base de données appartenant au monopole du copyright.

- Le domaine public doit être renforcé.

- La neutralité du Net doit être garantie.

- La levée d’impôts sur des médias vierges est mise hors-la-loi.

- De manière générale, la limite doit toujours être très clair. Les déclaration du genre « la justice en décidera » ne sont pas acceptables et sont équivalents à la mise hors-la-loi.

Cette proposition raisonnable, équilibrée, réalisable et réaliste résoudrait 99% des problèmes actuels, tout en maintenant l’ensemble des quatre aspects du monopole instauré par le copyright.

Cela mettait un terme à la chasse aux sorcières contre les ados qui téléchargent des séries télé. Cela résoudrait le problème des oeuvres orpheline, et nous rendrait l’accès à l’héritage culturel du XXème siècle. Et cela résoudrait le problème des contribuables payant l’industrie du copyright sans raison.

Par contre, cela maintiendrait un monopole commercial d’une durée maximale de 20 ans pour les investissements dans des productions culturels, battant en brêche l’argument avancé par l’industrie du copyright selon lequel l’établissement d’un monopole est nécessaire pour encourager la création culturelle.

Même si je ne suis pas d’accord avec les monopoles sur les brevets, il convient de noter que si les companies pharmaceutiques peuvent se contenter d’un monopole commercial de 20 ans (sur les brevets), alors cette durée devrait certainement convenir à Disney et Elvis aussi.

Ceci, ou quelque chose s’en approchant, est ce que nous devons faire. Nous devons reprendre l’offensive pour défendre notre liberté d’expression.

Notes

[1] Crédit photo : Petteri Sulonen (Creative Commons By)

Le 3 janvier dernier la Fondation Mozilla annonçait la sortie officielle de la version 2 de la Mozilla Public License.

C’est un évènement à saluer comme il se doit car cette nouvelle version rapproche les deux grandes familles de licences libres logicielles que sont les copyleft (comme la GPL) et les licences dites permissives (comme la BSD ou la MIT).

Pour résumer, on pourrait dire que la différence entre une licence libre avec copyleft et une licence libre qui en serait dépourvue, les premières forcent le code dérivé à rester libre alors que les secondes autorisent le code dérivé à être intégré à un produit fermé, non libre[1].

Mozilla peut-elle apporter l’unité à l’open source ?

Can Mozilla Unify Open Source?

Simon Phipps - 6 janvier 2012 - ComputerWorld.uk

(Traduction Framalang : Don Rico e_Jim et Goofy)

La nouvelle licence open source de Mozilla est bien plus qu’un simple ravalement de façade. Elle pourrait créer de nouvelles possibilités pour l’unité de la communauté du Libre.

La première semaine de janvier 2012 marque un jalon discret mais important dans le mouvement de l’open source, grâce à la publication d’une deuxième version de la Mozilla Public License (MPLv2) et sa validation en tant que licence libre officielle au sens de l’Open Source Initiative (OSI). Quand bien même beaucoup n’y voient qu’un énième détail juridique, cette publication est importante à deux titres : le procédé par lequel on l’a élaborée, et l’objectif pour lequel on l’a créée. Il s’agit d’une licence qui a pour but l’unité.

Rédaction et révision de cette licence se sont déroulées selon un processus très ouvert, dans lequel Luis Villa a joué un rôle prépondérant. Organisé en majeure partie dans des forums publics, le débat a conduit à de nombreuses modifications du texte. Luis est entré en contact très tôt avec l’OSI, a intégré les retours du groupe de révision des licences, puis obtenu sans mal l’approbation du conseil d’administration.

D’autres articles sur cette nouvelle licence se sont concentrés sur les modifications de la partie « patent peace » (NdT: la paix des brevets) et autres ajustements des clauses (adieu, Netscape !), mais le changement le plus important apporté par la version 2 de la licence Mozilla est à mon sens l’inclusion d’une compatibilité particulière avec la GPL (GNU General Public License). Par le passé, le projet Mozilla jonglait avec un système complexe et peu clair de triple licence afin de composer avec les univers des licences copyleft et non copyleft. De manière générale, les autres utilisateurs de la MPL (et ses nombreux clones rebaptisés) ne prenaient pas cette peine, et par conséquent certains codebases se sont retrouvés exclus de toute collaboration possible avec l’immense univers des logiciels placés sous licence GPL.

Selon un procédé inédit que la Commission européenne a inauguré pour la Licence Publique de l’Union européenne (EUPL), la MPLv2 inclut des clauses permettant à un projet de stipuler, de façon optionnelle et explicite, sa compatibilité avec d’autres licences, en particulier celles de la famille GPL. À mes yeux, la MPLv2 représente une mise à jour d’envergure de la famille précédente des v1.x, justement grâce à cette compatibilité explicite avec la GPL, laquelle offre pour la première fois une passerelle praticable entre les paradigmes permissifs et copyleft. Elle ne satisfera pas les puristes des deux mondes, mais propose avec pragmatisme une nouvelle solution aux projets open source appuyés par des entreprises. Celles-ci pourront disposer d’une communauté qui produit du code sous licence permissive tout en fournissant à cette même communauté un moyen d’entretenir des relations avec d’autres communautés travaillant sur du code sous licence copyleft.

Avec le déclin continu du business model de la double licence (ce que d’aucuns nomment « exceptions commerciales au copyleft »), il devient de plus en plus évident que les licences permissives sont importantes pour les entreprises commerciales qui contribuent à l’open source. De la même façon, l’écosystème GPL ne disparaîtra pas, aussi les conceptions qui reposent sur une opposition idéologique – y compris celles qui prônent l’élimination de tout code sous GPL – sont néfastes pour toutes les entreprises

Je salue l’arrivée de la MPLv2, un pas en avant vers l’unification de la cause commune de nombreux développeurs open source. Bravo, Mozilla !

Notes

[1] Crédit photo : Tristan Nitot (Creative Commons By-Nc-Sa)

Le jour viendra où lire tranquillement un livre dans un parc deviendra un acte de résistance.