Framablog - Archives (octobre 2012)

Issu du monde éducatif, Framasoft est un réseau de sites web collaboratifs à géométrie variable dont le dénominateur commun est le logiciel libre.

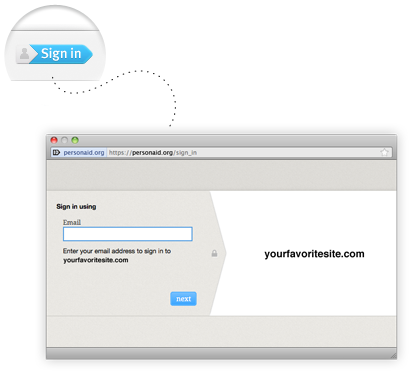

Ce n’est pas la première fois que nous vous proposons un témoignage raz-le-bol de Facebook qui joint la théorie à la pratique en décidant de quitter réellement le célèbre réseau social.

Après « la maman », voici « le musicien »… Et si ces deux cas isolés anticipaient un futur (et salutaire) mouvement de fond ?

Le constat va croissant, nombreux sont désormais les gens autour de moi qui n’aiment pas (ou plus) Facebook. L’attrait de la nouveauté envolé, les changement soudain de paramétrage qui désorientent et menacent notre vie privée, le temps passé dessus au détriment de « la vraie vie » (avec des morceaux de vrai(e)s ami(e)s dedans)… nombreuses sont les raisons qui font que la « douce saveur » du début a un arrière-gout de plus en plus amer.

Mais, contrairement à nos deux courageux, la grande majorité y reste pourtant, par habitude ou « parce que, vous comprenez, tout le monde est dessus ».

La parallèle est discutable mais ça me fait penser à tous ces utilisateurs, passés ou présents, enchaînés à leur système d’exploitation Windows. On finit par haïr Microsoft mais on en redemande quand même. Et cela porte un nom : addiction.

Facebook est le Windows de notre époque et il n’a toujours pas trouvé son GNU/Linux (puisqu’en l’occurrence notre musicien ne s’en va malheureusement pas beaucoup plus loin en choisissant Google+).

Facebook en voie de devenir le prochain MySpace ?

Is Facebook becoming the next MySpace?

Christian Grobmeier - 31 octobre 2012 - Blog personnel

(Traduction : lgnap, tiossanne, Yuston, ehsavoie, Yann, Gatitac, unnamed4, Naar, Damien, Maxauvy, Paul, Simon Villeneuve, 3josh)

Je suis musicien amateur. Bon, entre Time & Bill et d’autres projets me prenant tout mon temps, je suis actuellement un musicien « en pause », mais en 2005, j’étais plutôt actif et je me souviens que nous voulions sortir notre prochain CD. Tous mes amis musiciens étaient sur MySpace et nous parlaient de la pub efficace qu’ils pouvaient y faire. J’ai toujours trouvé le site laid, mais il y avait tellement de monde dessus que je m’y suis inscrit à mon tour, j’y ai déposé nos chansons et j’ai fait l’effort de construire un réseau. Ça a bien fonctionné pendant un moment. Ensuite, il est apparu qu’il y avait plus de musiciens que d’auditeurs sur le site. J’ai reçu des tonnes de messages comme « Écoute mon nouveau titre » ou « Viens à notre concert ». Les commentaires sur notre page ressemblaient à un grand mur couvert de pubs collées par d’autres musiciens. Parfois, parmi tous ces messages, on pouvait voir des femmes nues proposant leurs services. J’ai fini par fermer les commentaires. Puis MySpace a commencé à « faire mieux» (NdT : nouveau slogan du site). Ça a échoué, le site est simplement devenu plus lent, laid et inutilisable. Finalement, j’en suis parti et me suis préoccupé uniquement de notre site web. MySpace était un vrai bazar et n’avait plus aucune utilité.

Ensuite, tout le monde est passé à Facebook. J’y ai jeté un œil, sans être emballé. Il était difficile d’y mettre de la musique. Il y avait un côté restrictif et j’ai vraiment détesté l’interface utilisateur, mais bon, là encore tout le monde s’y est inscrit, et j’en ai donc fait de même. J’ai trouvé quelques applications tierces qui permettaient à mes visiteurs d’écouter ma musique. Tout allait bien. Après quelques temps, j’y ai même retrouvé avec émotion de vieux amis. Tout semblait aller pour le mieux.

C’est alors que les jeux sont arrivés. Tout à coup, ce fut le bazar. Eh, je ne veux pas gagner d’or, tuer des dragons ou cultiver des salades. Je suis juste là pour discuter avec des amis et échanger avec les fans de notre groupe. Cela empira au point de vouloir quitter Facebook lorsque j’ai découvert FBPurity. Et les choses s’arrangèrent. Quand j’ai découvert comment faire pour que Facebook arrête de m’envoyer des e-mails « Veux-tu jouer à ce jeu super ? », tout est rentré à nouveau en ordre, apparemment.

J’ai pendant longtemps ignoré toutes les discussions sur la confidentalité des données. Je ne publie rien de sensible sur Facebook. Les photos téléversées sont du tout-venant. Je ne réponds pas à toutes les questions que Facebook me pose. Ainsi, j’ai pu vivre avec le fait que Facebook fasait des choses vraiment étranges avec mon profil. À un moment, des clients m’ont ajouté à leur liste d’amis, j’ai donc dû devenir plus prudent avec mon profil. Il est probablement étrange pour mes clients de lire sur mon mur les invitations de ma maman à récolter de la salade sur Farmville, mais bon, ils doivent faire avec.

La confidentialité des données — est-ce vraiment un problème ? Parce que j’ai appris que la majeure partie du contenu sur Facebook est de la vraie foutaise. « Aïe, je me suis cassé un orteil » est l’un des messages les plus intéressants. Parfois, quelqu’un a un bébé, et si c’est un vieil ami, je le sais déjà. Si c’est une personne dont je n’ai pas entendu parler depuis des années, ce n’est pas aussi amusant que de lire les bêtises d’un autre ami dans un bar. Alors, quelles sont les « données importantes » dont nous nous préoccupons tous ? Si ce ne sont pas les absurdités que nous écrivons, c’est probablement lorsque nous cliquons sur « J’aime », parce que Facebook sait alors que nous aimons Coca-Cola et qu’il peut vendre notre profil client à n’importe qui.

Néanmoins, je peux accepter qu’ils vendent mes données pour me fournir un service apte à promouvoir mon groupe et garder contact avec avec mon réseau de relations, même si l’interface est toujours un cauchemar. Depuis le lancement de Google+, Facebook est devenu encore plus bordélique. Par exemple, il me faut toujours un temps fou pour ajouter des évènements à une page qui m’intéresse pour un ami.

Maintenant, qu’est-ce qu’on nous propose ? Des pubs partout,me forçant à utiliser AdBlock+ (j’y suis passé). Du contenu bien souvent sans intérêt et trop chronophage, je suis bien assez occupé comme ça. Mon profil est vendu à des inconnus. Ah, et au fait, j’oubliais : Facebook modifie pas mal de choses sans notification préalable.

Par exemple, vous ne pouvez plus cibler tous les fans de votre page lorsque vous postez un nouveau contenu. C’est vrai, Facebook me conseille maintenant de payer pour cela. Voici un billet intéressant à ce sujet qui décrit la situation. Après tout, il faut bien compenser la chute des actions en bourse…

À présent, Facebook a largement dépassé la moisissure qu’était Myspace. Non, je ne paierai pas pour ça, et je vais cesser de poster du contenu. Pourquoi continuerais-je à en poster si personne ne le lit ? Pourquoi paierais-je pour discuter de choses futiles et anodines avec mes amis ? Le téléphone est bien moins cher ! Pourquoi paierais-je pour la présence de mon groupe sur cette plateforme alors qu’il ne génère aucun revenu actuellement ?

Il en va souvent ainsi j’imagine, parfois, les grands réseaux sociaux oublient que les utilisateurs ne sont pas que des machines à fric, et aussi qu’ils peuvent partir. Je compte d’ailleurs quitter Facebook au profit de Google+. J’y poste déjà le contenu de tous mes blogs, si vous souhaitez me suivre. J’aime beaucoup son interface. ses bulles, ses cercles et son tchat vidéo. On y trouve du contenu de meilleure qualité que sur Facebook, et beaucoup de spécialistes sur un sujet donné.

Ce qui fait que Twitter et G+ sont désormais mes principaux canaux de communication. Du moins, jusqu’à ce qu’ils empirent. Twitter fait déjà des choses étranges, comme avec ses nouvelles modifications plus restrictives de l’API. Voyons ce que le futur nous réserve.

Enfin, je crois fermement qu’un jour, il y aura un réseau social décentralisé fondé sur des outils open source.

Adieu Facebook. Tu ne me manques pas.

Crédit photo : Phphoto2010 (Creative Commons By-Nd)

« J’ai encaissé deux fois plus d’argent en une seule journée que ce que je touche d’habitude en un mois ! »

Andy Othling est musicien. Il est guitariste de tournée pour Future of Forestry et il a enregistré des albums personnels sous le nom Lowercase Noises.

Sa musique est cool et planante :)

Mais ce qui est encore plus cool c’est la très originale et probante expérience qu’il vient de mener sur Internet.

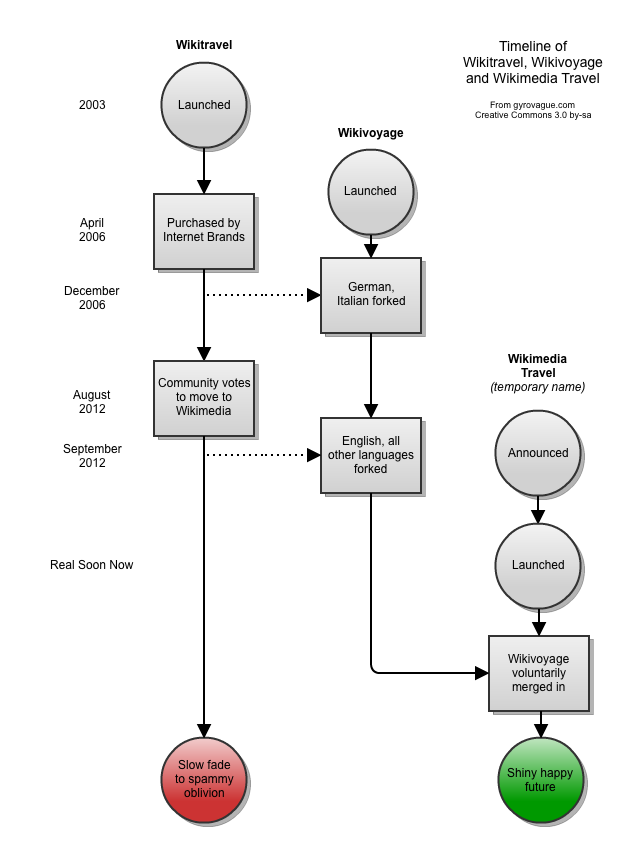

Sous le régime du copyright classique, ses albums sont présents sur le site de vente de musique en ligne Bandcamp (en passant cette plateforme est dans DRM et propose la format FLAC et Ogg Vorbis).

Présents et tous payants, sauf pendant 24h…

C’est le récit de cette folle journée qu’il vous raconte ci-dessous.

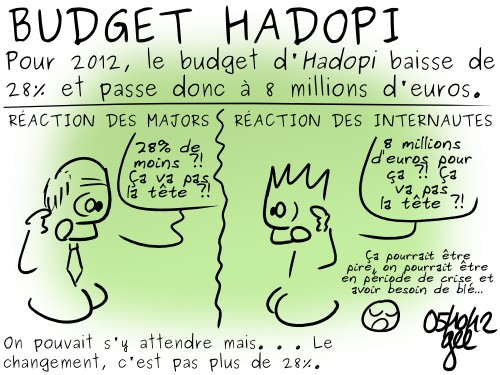

Attention, les conclusions pourront fortement heurter la sensibilité de certains hadopistes !

Que se passe-t-il lorsque votre musique est gratuite pendant une journée ?

What happens when your music is free for a day?

Andy Othling - 23 octobre 2012 - Blog personnel

(Traduction : Cyrille L., ehsavoie, Martin, Gatitac, Yann, ZeHiro, geecko, Naar, Sparty, Gaëtan, e-Jim, Tchevengour)

Il existe un débat houleux pour savoir si donner gratuitement sa musique est une bonne pratique ou non. Certains disent que cela dévalorise votre musique et vous empêche d’être pris au sérieux. D’autres pensent que c’est nécessaire pour attirer l’attention du public sur celle-ci.

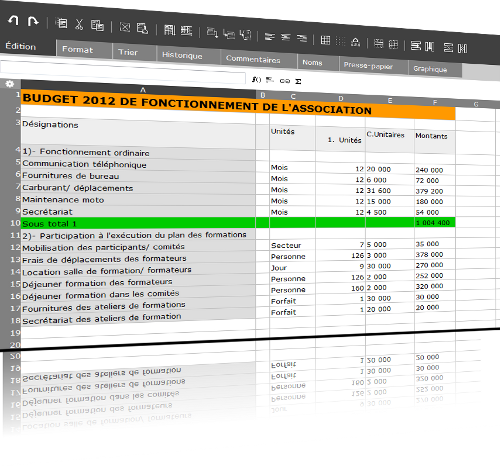

Ce billet n’est pas là pour vous faire adhérer à l’une ou l’autre de ces thèses, mais plutôt pour vous présenter les résultats d’une expérience que j’ai menée il y a quelques semaines. J’ai voulu voir ce qu’il se passerait si je mettais toute ma musique à prix libre (avec un minimum de 0 $) sur ma page Bandcamp pendant 24 heures.

Comment je m’y suis pris

Voici comment j’ai travaillé : j’ai programmé l’envoi d’un e-mail à ma liste de diffusion le 4 octobre à 1 heure du matin annonçant à tout le monde que toute ma musique était disponible à prix libre, à partir de 0 $, et leur indiquant de faire passer le message à toutes leurs connaissances.

J’ai aussi programmé des mises à jour de mes statuts Facebook et Twitter pour la même heure, en demandant aux gens de diffuser l’information les prochaines 24 heures. Ensuite, j’ai programmé des tweets toutes les 2 à 4 heures et des mises à jour du statut Facebook toutes les 4 à 6 heures durant les 24 heures de l’opération, afin de leur rappeler l’offre spéciale.

Les résultats

C’était attendu, l’un des résultats est que beaucoup plus de personnes ont eu accès à ma musique. Ils ont tapé 0 $ et ont téléchargé tout ce qu’ils voulaient gratuitement. Mais d’autres choses intéressantes se sont produites.

Sur Bandcamp, le nombre de téléchargements est le facteur principal de la notoriété.

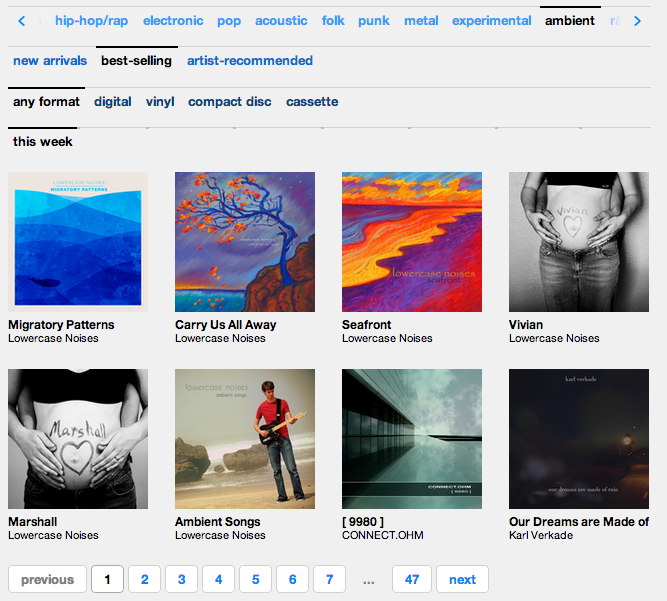

Puisqu’un grand nombre de personnes ont téléchargé ma musique (gratuitement ou non), mes albums furent propulsés en haut de beaucoup de listes du site. L’image ci-dessous montre les albums d’ambiance les plus vendus de ce jour si spécial :

Comme vous pouvez le voir, mes six albums sont directement en haut de cette section. Génial ! (Y voir aussi Karl Verdake me réjouis !)

Être en haut de ces listes, c’est plus de nouveaux visiteurs.

Parce que ma musique a atteint les sommets de certaines listes de Bandcamp, elle est devenue plus visible à ceux qui parcouraient ces listes ce jour-là. Ci-dessous, quelques captures d’écran des pages de statistiques de Bandcamp du jour J :

Plus de 100 personnes sont allées écouter ma musique depuis la page d’accueil de Bandcamp et 50 autres l’ont fait grâce aux listes mentionnées plus haut. Ce sont des personnes qui ne connaissaient pas même l’existence de ma musique.

Les gens se sont vraiment passés le mot.

Je n’ai eu aucune honte a demander aux gens de diffuser autour d’eux que mes morceaux restaient gratuits pendant ces 24 heures. Grâce à cela, quelqu’un a spontanément relayé l’info sur Reddit. Comme vous pouvez le voir ci-dessous, cela m’a apporté encore plus de nouveaux auditeurs :

Une fois de plus, 202 nouveaux auditeurs rien qu’en demandant aux gens d’en parler autour d’eux !

Les gens continuaient de payer pour ma musique.

Maintenant, vous vous demandez probablement qu’est-ce que ça a donné en terme de rentabilité. J’avais prévu une chute des revenus, car c’est généralement ce à quoi on s’attend quand on commence à distribuer les choses sans contrepartie. Mais ce qui est en fait arrivé, c’est que, sur les ventes, j’ai encaissé deux fois plus en une seule journée que ce que je touche d’habitude EN UN MOIS. Oui, parfaitement, vous lisez bien. Une journée a davantage rapporté que deux mois en temps normal !

Je ne suis pas vraiment capable d’expliquer cela, mais je pense que ça s’est joué pour beaucoup sur la générosité réciproque. Les gens ont vraiment semblé apprécier que je fasse ce geste et ont répondu en donnant plus qu’ils ne le faisaient auparavant. J’ai ainsi été stupéfait par ceux qui ont décidé de donner davantage pour un album que le prix qu’il leur aurait coûté la veille.

Le plus important : les contacts

Plus d’argent, c’est génial, mais à mon avis ce n’est pas le plus grand succès de cette expérience.

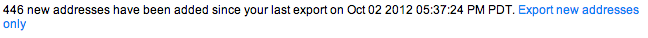

Vous pouvez constater qu’en une journée, j’ai ajouté plus de 450 noms à mon carnet d’adresses. Ce sont 450 nouveaux contacts dont je pourrais bénéficier à l’avenir, et 450 personnes de plus qui peuvent à leur tour relayer l’info si jamais je venais à répéter ce genre d’opération. C’est bien plus important à mes yeux que l’argent.

Récapitulatif

Donc, que s’est-t-il passé là?

- Beaucoup de personnes ont récupéré ma musique gratuitement ;

- J’ai gagné beaucoup d’argent de manière inattendue ;

- J’ai de nouveaux auditeurs et des contacts pour mes prochaines sorties d’albums.

D’après moi, c’est du gagnant-gagnant. Il n’y a vraiment eu aucun coût pour moi à réaliser cette expérience, les gains se sont avérés énormes et mes auditeurs n’ont pas été abusés. Pour ne rien vous cacher mon taux de téléchargements payants a baissé de 22% à 8%, mais étant donné tout ce qui est arrivé, cela ne me gêne pas le moins du monde.

Alors, que cela signifie-t-il pour vous en tant qu’artiste ? C’est un peu plus dur à dire, étant donné que cela dépend de ce que vous avez mis en place et que la situation de chacun est différente. Mais, cela montre au moins l’importance de l’expérimentation. N’hésitez pas à essayer des choses pour voir à quoi vos fans vont réagir. Vous devez apprendre d’eux comme ils ont appris de vous.

Question : Et vous, avez-vous déjà proposé votre musique gratuitement ou bien à prix libre ? Cela a-t-il fonctionné ?

Crédit photo : Knate Myers

Le loi de Moore (qui n’est en fait qu’un conjecture) affirme que le nombre de transistors des microprocesseurs sur une puce de silicium double tous les deux ans. Ce qui, par extension, a donné pour le grand public que le rapport entre la puissance d’un ordinateur et son prix double tous les dix-huit mois.

Autrement dit, les machines sont de plus en plus puissantes et de moins en moins chères.

C’est bien ce qu’il s’est produit et se produit encore, pour le plus grand bonheur du logiciel libre et sa culture…

Un allié secret de l’open source : la loi de Moore

Open source’s secret ally: Moore’s Law

Glyn Moody - 10 octobre 2012 - The H

(Traduction : KoS, ProgVal, Sylvain, greygjhart)

Linux est passé du statut de petit bidouillage sympa dans une chambre à celui de logiciel capable de changer le monde il y a un peu plus de 21 ans lorsque Linus a envoyé son fameux message : « Bonjour aux utilisateurs de minix », invitant les gens à le rejoindre. Comme je l’ai remarqué le mois dernier, cette approche ouverte, collaborative était tout à fait nouvelle et s’est avérée décisive dans l’adoption et le développement de Linux.

Cela fut possible car Internet était déjà suffisamment présent pour qu’assez de gens se joignent à l’équipe distribuée de volontaires de Linus. En d’autres termes, l’émergence du logiciel libre est intimement liée à internet. En effet, le décollage rapide de Linux, comparé aux progrès plutôt lents du projet GNU est probablement dû, au moins en partie, au fait que ce dernier ne pouvait se reposer sur une connectivité globale. C’est grâce à cela que Richard Stallman a pu vivre des ventes de GNU Emacs, qu’il distribuait sur des bandes magnétiques.

La nature symbiotique du logiciel libre et d’internet, le premier utilisant le second, le second étant utilisé par le premier, est maintenant largement reconnue. Mais un autre facteur clé dans l’apparition de l’open source a été sous-estimé, alors que Linus lui-même le mentionne dans ce fameux premier message :

Je programme un système d’exploitation (gratuit, c’est juste un passe-temps, ça ne sera pas un gros projet professionnel comme GNU) pour des clones AT 386(486).

Comme nous vivons à l’ère Intel depuis deux décennies, une ère qui touche peut-être à sa fin, avec la montée en puissance des smartphones et des tablettes et leurs processeurs de familles différentes, il est facile de négliger l’importance du fait que Linus développa Linux pour les processeurs 80386.

Aussi étrange que cela puisse paraître , l’ordinateur principal de Linus avant qu’il n’écrive Linux était un Sinclair QL, un ordinateur typiquement anglais qui utilisait le processeur Motorola 68008 (qui fonctionnait à 7,5 MHz), fourni avec 128K de RAM et utilisait un infâme microdrive comme stockage.

Passer à un PC 386, fonctionnant à 33MHz, avec 8 Mo de RAM et 40Mo de disque dur, était un véritable bond en avant pour Linus, et poussa ses finances à leurs limites. En fait, il n’a pu acheter son premier PC que le 5 janvier 1991 parce qu’il reçut de l’argent pour Noël qu’il ajouta à un prêt étudiant que le gouvernement Finlandais lui avait récemment accordé. Ce dernier était sensé payer sa nourriture et son logement pendant qu’il étudiait à l’université d’Helsinki mais comme il vivait toujours avec sa mère pendant cette période, il réussi à le détourner pour un usage plus intéressant.

Le fait qu’il puisse se payer un système aussi performant reposait sur l’amélioration continuelle du matériel, couplée à la diminution régulière des prix. C’est à dire que c’est grâce à la loi de Moore, qui dit que le ratio entre performances et prix double tous les 18 mois environ, que Linus a pu se retrouver avec le système 386 qu’il mentionne dans le premier message sur Linux.

Sans la loi de Moore, il serait sans-doute resté avec son Sinclair QL, codant pour un système dont peu de gens se souciaient. Avec le 386, il a pu rentrer dans le courant dominant de l’informatique en même temps que de nombreuses autres personnes. Partout dans le monde (ou en tout cas dans les zones les plus riches) les jeunes gens ont pu s’acheter de vrais ordinateurs basés sur l’Intel 80386 et (plus tard) 80486. Cela signifiait qu’ils pouvaient faire tourner le code de Linux dès ses débuts, et aussi qu’ils pouvaient contribuer.

Encore une fois, sans la loi de Moore mettant des ordinateurs moins chers dans les mains de bidouilleurs, Linus n’aurait pas été en mesure de construire cette communauté mondiale à travers Internet et le rythme de développement en aurait souffert. En effet, comme la loi de Moore continuait de tirer les prix vers le bas tout en augmentant les performances, de plus en plus de gens dans un nombre croissant de pays ont pu acquérir des PCs suffisamment puissants pour rejoindre le projet Linux. Des processeurs plus rapides signifiaient des temps de compilation plus courts pour les programmes ce qui rendait le bidouillage du code plus facile - et plus agréable.

Il y a ici un contraste intéressant avec le développement du logiciel propriétaire. Les avancées dues à la loi de Moore ne profitent que peu aux programmeurs dans les entreprises, puisqu’ils ont généralement du matériel assez bon. Et les entreprises n’en bénéficient guère plus, puisque ce qui coûte le plus dans la programmation est le salaire des programmeurs, pas le prix de leurs PCs. Dans le monde du logiciel libre, les programmeurs volontaires sont bénévoles et le facteur limitant est le prix du matériel. C’est pourquoi la loi de Moore est très avantageuse pour l’open source.

Potentiel futur

Ce n’est pas un effet purement historique des premières heures de Linux. Nous voyons encore aujourd’hui la Loi de Moore tirer les prix vers le bas en accueillant toujours plus d’utilisateurs. Un bon exemple est le mini-ordinateur Raspberry Pi. Il offre les bases de la puissance d’un PC sur une petite carte mère, à un prix minuscule. Cela signifie que non seulement les personnes ordinaires – même des enfants – peuvent l’acheter sans avoir à penser au prix, mais aussi que les écoles peuvent envisager d’en acheter un pour chaque étudiant, ce qui est normalement inenvisageable avec les prix prohibitifs des PC, même ceux bon marché.

L’effet que le Raspberry Pi aura sur l’éducation n’est pas encore clair, mais il semble que celui-ci ou l’un des nombreux systèmes semblables à prix très bas va permettre l’arrivée de nouveaux types de projets avec des nouveaux groupes de contributeurs, dans les pays émergents par exemple.

Et les choses sont déjà en train d’aller plus loin. Voici un projet Kickstarter qui illustre à merveille cette progression continue rendue possible grâce à la loi de Moore. Il s’agit de Parallella. l se décrit comme un « Supercalculateur Grand Public », et ce n’est pas une blague.

Une fois terminé, l’ordinateur Parallella devrait fournir l’équivalent d’un processeur à plus de 45Ghz sur un circuit de la taille d’une carte de crédit tout en consommant moins de 5 Watts en fonctionnement normal. En s’en tenant seulement à la fréquence, c’est plus de puissance qu’un serveur haut de gamme qui coûte des milliers de dollars et consomme 400W.

Important, tout le système sera ouvert :

- Accès ouvert : absolument aucun accord de non divulgation ou accès spéciaux nécessaires ! Toute l’architecture et le kit de développement seront publiés sur le web dès que le projet sera financé sur Kickstarter.

- Open Source: la plateforme Parallella sera basée sur des outils et des librairies libres et gratuites. Tous les fichiers de conception des circuits seront fournis une fois que Parallella sera sur le marché

- Bon marché : les coûts du matériel et des outils de développement ont toujours été une barrière très difficile à franchir pour les développeurs cherchant à écrire des applications haute-performance. Notre but est de fournir l’ordinateur haute-performance Parallella à un coût inférieur à 100$, le rendant accessible à tous.

Oui, c’est un super ordinateur à 45GHz, fourni en standard avec Ubuntu, pour moins de 100$. Si Parallella parvient à sortir cela - et en tant que projet Kickstarter (il y a toujours le risque qu’il ne soit pas totalement financé ou qu’il ne fonctionne pas correctement) il va mettre un nouveau niveau de puissance de calcul entre les mains de tout le monde, y compris les étudiants.

Potentiellement, cela va permettre à des gens qui, jusqu’à présent, ne pouvaient tout simplement pas s’acheter une telle puissance de calcul de démarrer une toute nouvelle génération de projets open source. Encore une fois, le principal bénéficiaire ici est l’open source : si une entreprise a besoin d’un supercalculateur, elle va généralement l’acheter immédiatement, puisqu’elle peut se permettre de payer un prix conséquent pour les modèles actuels. Ce que Parallella apporte, grâce à la loi de Moore, est la démocratisation d’une puissance de calcul de cet ordre, qui ne va plus être réservée à des projets commerciaux disposant de solides fonds.

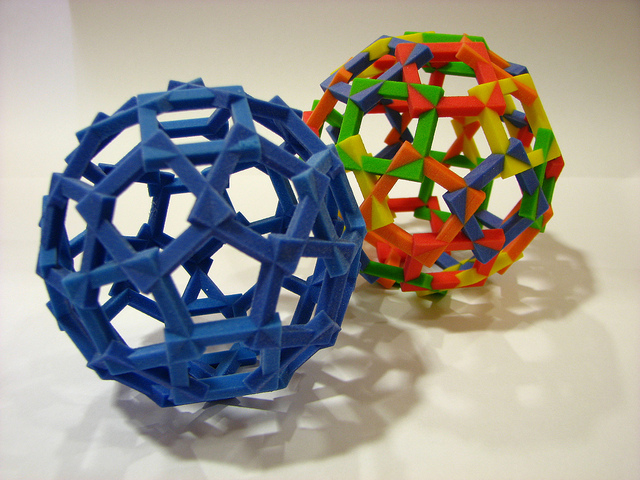

Il est important de noter que c’est la loi de Moore, agissant sur le matériel qui apporte ces bénéfices, plutôt que n’importe quel changement exponentiel dans le logiciel (qui n’y contribue qu’indirectement). De plus des la loi de Moore pour d’autres types de matériel commencent également à prendre forme. Un exemple frappant en est l’impression 3D, où les prix baissent régulièrement. Ou encore le monde du séquençage du génome, démêler les milliards de « lettres » chimiques qui forment la double hélice de l’ADN, qui voit l’arrivée de changements encore plus importants.

Vous savez peut-être que le coût de séquençage du génome baisse mais vous n’avez peut-être pas la moindre idée de la vitesse à laquelle il baisse. Le National Human Genome Research Institute qui fait partie du National Institute of Health américain a compilé des données étendues sur le coût de séquençage de l’ADN au cours de la dernière décennie et a utilisé ces informations pour créer deux graphique à couper le souffle. Les chercheurs du NHGRI montrent que non seulement les coûts de séquençage sont en chute libre mais ils dépassent la courbe exponentielle de la loi de Moore d’une grande marge.

Cela signifie que le coût de séquençage de votre génome, ou de n’importe quel autre organisme, va bientôt devenir à la portée de tout le monde. Cela va-t-il créer une communauté globale de bio-hackers libristes, menée par un nouveau Linus avec un séquenceur de bureau (et peut-être un supercalculateur Parallella) dans sa chambre à coucher ? L’expérience des logiciels libres suggèrent que oui et nous apprend que nous ne devrions jamais sous-estimer le simple pouvoir de la loi de Moore à conduire des changement inattendus et révolutionnaires.

Crédit photo : Leonardo Rizzi (Creative Commons By-Sa)

Excellent accélérateur de migration Windows vers GNU/Linux, Framasoft soutient et promeut depuis le début la distribution grand public Ubuntu. Et ce ne sont ni les annotations de Richard Stallman ni la récente « affaire Amazon » (fort bien explicitée par Christophe Sauthier) qui nous feront changer d’avis.

Mais cela ne nous empêche pas dans ces colonnes de traduire de temps en temps des articles parfois critiques à son égard, au risque de déclencher des ires dans les commentaires ;)

Ici le journaliste Sam Varghese reproche à Mark Shuttleworth de ne pas avoir clairement affirmé, et ce dès l’origine, le caractère commercial d’Ubuntu intimement liée à sa société Canonical. C’est ce qui explique pour lui que cette histoire avec Amazon a été si mal prise pour la communauté.

Et de citer alors en exemple la société Red Hat qui lui semble plus claire dans ses objectifs (de profits). D’ailleurs cette dernière propose deux distributions plutôt qu’une : la « commerciale » Red Hat Enterprise Linux et la « communautaire » Fedora.

Il est d’ailleurs possible que cette éventuelle confusion soit encore plus forte dans des pays comme la France où la communauté Ubuntu est très dynamique.

Il est vrai qu’une fois qu’on découvre GNU/Linux (souvent avec Ubuntu), on s’aperçoit qu’il existe bien des différences entre les distributions. Le très pratique mais pas très libre Linux Mint n’est pas la même que la moins pratique mais très libre Triskel. La gouvernance et finalité d’une Debian diffèrent sensiblement de celle d’Ubuntu qui s’en est inspirée à la base.

C’est toute la richesse et diversité du logiciel libre et c’est très bien ainsi, non ?

La grande erreur de Mark Shuttleworth

Mark Shuttleworth’s big mistake

Sam Varghese - 26 octobre 2012 - ITWire.com

(Traduction : peupleLa, Bob Young, KoS, Yuston, Gatitac, HgO, greygjhart)

La semaine dernière a marqué le huitième anniversaire de l’apparition d’Ubuntu sur la scène GNU/Linux. Depuis octobre 2004, de nouvelles versions de cette distribution sont sorties tous les six mois : le buzz initial a été très fort avant de s’estomper peu à peu.

Il est remarquable qu’au fil des ans, chaque fois que Mark Shuttleworth, l’homme qui possède Canonical, la compagnie qui est derrière Ubuntu, introduit une nouvelle fonctionnalité destinée à générer des revenus, des cris et des pleurs se font entendre. Alors, les gens d’Ubuntu essaient de s’expliquer et pour finir, on trouve un semi-compromis qui ne satisfait personne.

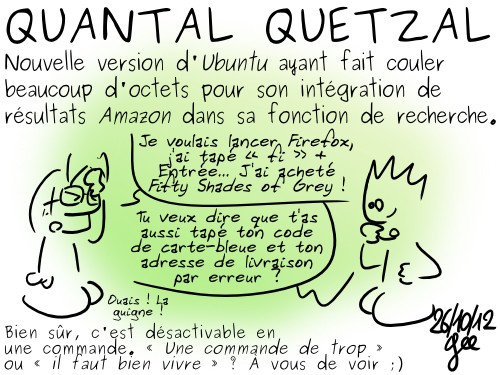

La dernière de ces fonctionnalités, dans la version 12.10, fut l’ajout des résultats de recherche d’Amazon aux résultats de recherche habituels. Ce qui signifie un peu d’argent venant d’Amazon pour Canonical (à chaque fois qu’un utilisateur d’Ubuntu achète un produit Amazon à partir de la recherche). Le compromis a été d’en faire une fonctionnalité optionnelle.

De telles situations se sont déjà produites par le passé, et se reproduiront encore à l’avenir. Il y a selon moi une raison simple à cela : Mark Shuttleworth n’a pas réussi à formuler une vision claire du projet Ubuntu à ses débuts. Grave erreur.

Lorsqu’Ubuntu est sortie pour la première fois, il y a eu beaucoup de discussions à propos de la signification de la formule : l’humanité en partage (NdT : humanity to others). Il y avait un tas de fonctionnalités cools, qui mettaient l’accent sur l’implication de la « communauté ». Des cédéroms étaient livrés gratuitement aux gens. On aurait dit une œuvre de bienfaisance du logiciel libre gonflée aux stéroïdes. Ou à l’EPO, à la Lance Armstrong (en français dans le texte) si vous préférez.

Mais il n’y a jamais eu de discussions à propos du fait qu’Ubuntu est une distribution commerciale ; elle a besoin de générer du profit pour exister. Shuttleworth a les poches profondes mais elles ne sont pas sans fond. Le logiciel a beau être gratuit, il faut néanmoins que les comptes atteignent un jour l’équilibre.

À l’opposé, lorsque Red Hat, de loin l’entreprise générant le plus de profits grâce à GNU/Linux, est née, en 1994, tout le monde savait que son but était de générer de l’argent grâce au système d’exploitation libre. Il n’y avait pas d’illusions. C’est pourquoi en 1997, lorsque j’ai pour la première fois entendu parler de GNU/Linux, la communauté du logiciel libre surnommait déjà Red Hat la « Microsoft » des distributions Linux !

Mais au fil des ans, Red Hat a acquis beaucoup de karma positif auprès de la communauté. Elle contribue largement au progrès de Linux en recrutant une bonne partie des développeurs contibuant au noyau. Elle finance des activités périphériques pour participer à la croissance de l’écosystème des logiciels libres.

Personne n’a dit le moindre mal d’Ubuntu à ses débuts. Mais à certains moments en cours de route, quand il s’agissait d’incorporer des fonctionnalités en vue de générer des revenus, les utilisateurs se sont dressés en masse. On ne peut pas leur en vouloir; ils avaient été amenés à croire que la communauté était primordiale et ils ont réagi.

Après quelques-unes de ces confrontations, Shuttleworth a levé le pied et poursuivi sur le chemin qu’il avait choisi. Il ne pouvait pas vraiment faire autrement, après les critiques d’abords douces puis amères soulevées par ses tentatives progressives d’introduire des fonctionnalités commerciales.

Les membres de la communeauté n’ont rien contre ceux qui gagnent de l’argent grâce à des logiciels libres. Patrick Volkerding, créateur et mainteneur principal de la distribution Slackware, est considéré par beaucoup comme un héros pour avoir toujours fourni à ses utilisateurs la distribution qu’ils voulaient. En retour, ces utilisateurs achètent tout ce qu’il produit pour qu’il gagne de l’argent et continue son travail. Et sa distribution est demeurée bénéficiaire la majeure partie de son existence.

Mais Shuttleworth a plus ou moins creusé sa propre tombe. Il aurait dû être clair quant au chemin qu’il allait prendre, clair à propos de son but, et faire attention à ce que son plan soit transparent. Une société basée sur GNU/Linux doit tracer son chemin différemment d’une société ordinaire ; peut être que Shuttleworth n’en avait pas conscience.

Quelle qu’en soit la raison, son manque de communication a abouti à ce qui s’est produit avec les résultats de recherche Amazon et ce qui s’en suivra. C’était la grosse erreur de Mark Shuttleworth.

Crédit photo : Stephen Walli (Creative Commons By-Sa)

Notre premier billet consacré à l’impression 3D date de 2008. Depuis cette technologie a fait de gros progrès, elle frappe déjà à la porte de nos maisons pour le plus grand bénéfice de tous. Et tous les espoirs sont permis puisque l’esprit du libre s’est penché dès le départ sur son berceau.

Sauf qu’ici comme ailleurs, nous ne sommes pas au pays de bisounours et la résistance de l’ancien monde sera à n’en pas douter dure et acharnée. C’est d’ailleurs pour être prêts en amont que nous avons déjà publié ces deux articles : L’impression 3D, ce sera formidable… s’ils ne foutent pas tout en l’air ! et Ils tenteront de nous pourrir l’impression 3D avec leurs DRM.

Comme cela est déjà le cas pour le logiciel, de nombreuses attaques viendront du côté des brevets (et la récente affaire Apple Samsung n’est pas faite pour nous rassurer).

Heureusement la législation américaine a mis en place une nouvelle procédure qui permet à tout citoyen de participer au processus de validation (ou non) d’un brevet. C’est ce droit de vigilance que se propose d’exercer l’Electronic Frontier Foundation (ou EFF) avec nous.

Oui, cela ne concerne (pour le moment) que les États-Unis mais dans ce domaine on sait très bien que ce sont eux qui donnent le la au niveau mondial.

Rejoignez les efforts de l’EFF pour que l’impression 3D reste libre

Join EFF’s Efforts to Keep 3D Printing Open

Julie Samuels - 24 octobre 2012 - EFF.org

(Traduction : KoS, Ward, PostBlue, tibs, Simounet, Ag3m, Damien, Jeff_, HgO, Aylham, 4nti7rust)

Grâce à la communauté « open hardware » (NdT : ou matériel libre), vous pouvez maintenant posséder une imprimante 3D pour quelques centaines de dollars, avec des douzaines de modèles disponibles. Ces imprimantes conçues par la communauté surclassent déjà les modèles propriétaires qui coûtent pourtant 30 fois plus cher. Cette innovation incroyable est possible grâce à l’expiration, il y a plusieurs années, du brevet principal couvrant les technologies de l’impression 3D, ce qui a permis à des projets comme RepRap de prouver ce que nous savions déjà, à savoir que le libre dépasse souvent le système de brevets pour stimuler l’innovation.

Les matériels d’impression libres ont déjà été utilisés pour le prototypage rapide de nouvelles inventions, pour imprimer des pièces de remplacement d’objets d’appareils domestiques, par des maîtres du bricolage pour transformer une perceuse en centrifugeuse, pour des jeux où nous pouvons créer nos propres pièces, et pour des milliers d’autres choses par des gens de tous horizons. Des projets comme MakerBot et Solidoodle ont rendu les imprimantes 3D aussi faciles d’accès qu’un dispositif plug&play, où vous n’avez même plus à souder quoi que se soit pour commencer à manufacturer des objets que vous avez dessiné ou dont vous avez téléchargé les plans sur Internet. Avec l’expiration des brevets, la communauté de l’open hardware sera en mesure de libérer son esprit créatif sur les nouvelles technologies, des technologies qui ont déjà été utilisées pour concevoir des prothèses personnalisées, des guitares, des chaussures, et plus encore. Les possibilités sont illimitées (NdT : traduit ici par le Framablog).

Le Problème

Alors que les principaux brevets restreignant l’impression 3D ont expiré ou sont sur le point de l’être, il existe un risque que les creative patent (NdT : brevets sur les idées) continuent de verrouiller les idées au-delà des 20 ans initialement prévus pour ces brevets, ou qu’ils ne restreignent les avancées futures de la communauté open source. Alors même que, nous le savons, la nature incrémentielle des innovations sur l’impression 3D la rend particulièrement inéligible pour les brevets.

Le projet

Comme nous l’avons dit précédemment , l’America Invents Act n’a pas réussi à corriger le problème de l’excessive brevetabilité. Malgré on y trouve au moins une clause récente qui, nous le pensons, pourra être utile : le Preissuance Process.

Cette procédure autorise des tiers à participer au processus de dépôt de brevets en ayant la possibilité d’informer les examinateurs de l’état antérieur de la technique en question. Nous sommes fiers de voir que le Patent Office (NdT : Bureau des Brevets) a ouvert le processus à ceux qui ne déposeront probablement pas de brevets eux-même, mais qui en seront impactés dans leur vie quotidienne. Nous sommes content de savoir que ce nouvelle procédure pourra aider à endiguer la déferlante de brevets illégitimes.

L’EFF et la Cyberlaw Clinic au Centre Berkman de Harvard pour l’Internet et la Société travaillent ensemble pour utiliser cette nouvelle procédure afin de mettre à l’épreuve les dépôts de brevets qui menacent particulièrement les technologies d’impression 3D en plein développement. En premier lieu, nous évaluons les dépôts de brevets sur l’impression 3D qui sont actuellement en cours devant le Patent Office pour identifier de potentiels dangers. Nous avons besoin de vous ! Si vous connaissez des applications qui couvrent les technologies d’impression 3D et qui selon vous devraient être contestées, faites-le nous savoir par mail à 3Dprinting@eff.org (indiquez nous également tous les précédents pertinents que vous connaîtriez).

Pour s’impliquer, il est possible de se rendre sur l’outil de recherche du USPTO (NdT : Bureau de gestion des brevets et des marques déposées des États-Unis), du PAIR (NdT : Récupération d’informations des dépôt de brevets) et/ou de Google Patents. Chacune de ces sources contient de nombreux détails sur les brevets actuellement en attente de validation au USPTO.

Voilà le problème : avec les lois en vigueur, un dépôt de brevet ne peut être contestée par la Preissuance Submission que dans les six mois suivant sa publication (ou avant la date du premier rejet, si cette action se passe après). Ce qui signifie que le compte à rebours a déjà commencé pour les rejets concernant les dépôts de brevet en cours.

Une fois les cibles identifiées, nous nous renseignerons sur les précédents pertinents. Nous vous demanderons à nouveau votre aide à ce moment là, alors, s’il vous plait, soyez vigilants. Tout document disponible publiquement avant le dépôt d’un brevet est considéré comme un précédent; cela peut inclure des e-mails sur des listes publiques, des sites internet, et même des thèses universitaires. En raison de la limite temporelle, nous devons effectuer ces recherches très rapidement.

Il est heureux d’avoir à disposition cette nouvelle façon de combattre le dépôt de brevets dangereux avant qu’ils ne deviennent réellement dangereux. Mais l’America Invents Act et les capacités de recherche du site du Patent Office ne nous rendent pas la tâche aisée. Nous avons besoin de votre aide pour pouvoir accomplir cela, alors s’il vous plaît, faites ce que vous pouvez pour aider à protéger la communauté de l’impression 3D des brevets flous et nocifs qui peuvent menacer de passionnantes innovations.

Crédit photo : Fdecomite (Creative Commons By)

Il y a 3 ans nous traduisions un article issu du blog de Google et rédigé par l’un de ses hauts gradés Jonathan Rosenberg : The meaning of open. Il y expliquait pourquoi et comment la célèbre entreprise prônait l’ouverture à tous ses étages.

Le même auteur récidive ici en dépassant la problématique Google pour affirmer non sans un certain optimiste (à l’américaine) que c’est le futur tout entier qui est désormais ouvert et que c’est très bien comme ça.

Remarque 1 : Nous avons choisi de traduire tout du long « open » par « ouverture » ou « ouvert ». L’adéquation n’est pas totalement satisfaisante, mais laisser le terme d’origine en anglais eut été selon nous plus encore source de confusion.

Remarque 2 (troll et hors-sujet ?) : À comparer avec la situation française où l’on semble actuellement beaucoup plus préoccupé de savoir ce que nous prend ou nous donne l’État que de promouvoir ou pratiquer l’ouverture. Sans oublier, évidemment, la fameuse taxe Google qui « sauvera » la presse !

Le futur est ouvert

Jonathan Rosenberg - octobre 2012 - ThinkWithGoogle.com

(Traduction Framalang : nobo, peupleLa, KoS, Smonff, ehsavoie, tibs, Louson, goofy, Khyvodul, Pandark, lgodard, Kiwileaks)

Il y a trois ans, Jonathan Rosenberg, alors vice-président délégué à la gestion de la production, a écrit un mémo (NdT : que nous avions traduit) expliquant pourquoi les entreprises ouvertes seraient les gagnantes du futur. Aujourd’hui, consultant au service du management, il a vu la réalité dépasser ses rêves les plus fous.

Il y a bientôt trois ans, en décembre, j’ai envoyé un courriel à mes chers collègues de Google, pour essayer de donner une définition claire d’un terme galvaudé : Ouvert. Je trouvais gênant qu’entre nos murs, il prenne différents sens selon les personnes, et que trop de Googlers ne comprennent pas l’engagement fondamental de l’entreprise pour ce qui est ouvert. En me référant à la fois aux technologies ouvertes et aux informations ouvertes, j’ai présenté la philosophie sous-jacente à notre volonté de transparence. Rechercher des systèmes ouverts, avais-je argumenté, nous a menés, et continuera de nous mener vers deux résultats souhaitables : Google devient meilleur, et le monde avec lui.

L’argument était convaincant, et plus tard, un billet sur le blog de Google , « The Meaning of Open », permit de clarifier encore plus ce concept parfois difficile à appréhender. Dans les semaines qui ont suivi, j’ai reçu des messages pleins de profondeur de la part d’un public divers et varié : enseignants ou écrivains qui appréciaient ce point de vue de l’intérieur de Google, chefs d’entreprise qui m’expliquaient comment l’ouverture avait influencé leurs affaires, étudiants surpris d’une position qui allait entièrement à l’encontre de la stratégie de fermeture qu’on leur avait enseignée. Trois ans ont passé, et ce qui me saute aux yeux dans ce manifeste c’est que… j’avais tort !

On ne peut pas dire que le développement ouvert n’ait pas fait progresser Google et le reste du monde. Seulement c’est arrivé beaucoup plus vite que je ne l’avais imaginé. C’est au beau milieu d’un des gestes les plus banals du vingt-et-unième siècle que j’en ai pris conscience : je vérifiais mon téléphone, un Droid Razr Maxx. Je fixais la chose, et j’en voyais toute la diversité : deux douzaines d’applications, du New York Times à Flipboard, de Dialer One à OpenTable, de RunKeeper à SlingPlayer, créées par un tas de développeurs différents, sur un téléphone conçu par Motorola. Il m’est apparu que ce que je regardais n’était pas simplement un appareil mobile, mais l’incarnation physique de la façon dont un écosystème ouvert peut se disséminer à travers le monde presque du jour au lendemain.

Sans aucun doute, j’ai toujours senti que cette idée tenait debout – mais je n’avais pas anticipé l’ampleur avec laquelle les règles du jeu entre les secteurs privés et publics allaient être réécrites. C’est la conséquence de trois tendances techniques qui ont évolué à une vitesse étonnante. Premièrement : Internet rend l’information plus libre et omniprésente que ce que j’aurais pu croire ; pratiquement tout ce qui se passait hors ligne est maintenant en ligne. Deuxièmement : ce qui était une vision du potentiel des mobiles est vraiment devenu réalité, puisque les machines sont devenues plus puissantes et plus rapides que prévu, facilitant une portée globale et une connectivité sans précédent. Troisièmement : l’informatique dans le nuage (NdT : Cloud computing) a permis une puissance de calcul infinie à la demande. Et nous sommes loin d’avoir fini. Alors même que j’écris ces lignes, Google Fiber s’apprête à déployer un service à un gigabit à Kansas City, indice que la connectivité est sur le point de franchir une nouvelle limite.

La conjonction des de ces progrès techniques a un effet paradoxal : aussi nouveaux soient-ils, ils finissent par ramener les entreprises aux fondamentaux. La gamme et la qualité des produits sont maintenant les facteurs les plus importants pour déterminer le succès d’une entreprise. Historiquement, les entreprises pouvaient profiter d’une pénurie d’information, de connectivité ou de puissance de calcul pour attirer et conserver leurs clients et repousser les concurrents.

De nos jours, les clients peuvent prendre des décisions bien plus éclairées en accédant aux informations des autres consommateurs. En effet, ils renforcent mutuellement leur pouvoir de décision par leurs échanges via des sites comme Yelp et toute une flopée de réseaux sociaux. Une société ne peut plus complètement contrôler l’environnement de ses clients. Au moment où les frontières de la distribution se sont effondrées – pensez aux moyens de transports mondialisés et bon marché, pensez aux étalages infinis des détaillants en ligne – les consommateurs ont de plus en plus de contrôle par eux-mêmes. Avec ce nouveau paradigme, et des marchés toujours plus compétitifs, les sociétés n’ont plus d’autre choix que de se concentrer sur la qualité et les gammes de produits. Si elles ne le font pas, une autre le fera à leur place.

Avec autant de changements en si peu de temps la nécessité de l’ouverture s’est imposée comme une tactique commerciale décisive pour atteindre à la fois l’excellence et la déclinaison des produits. Ouvrir un produit à toute une armée de créatifs est le plus court chemin pour créer de l’innovation et de la diversité, puisque cela permet à chaque contributeur de se focaliser sur ce qu’il fait le mieux et que cela encourage les contributions d’un public le plus large possible.

Chrome et Android, qui ont tous deux décollé depuis que « The Meaning of Open » a été publié, illustrent parfaitement ce principe. Avec chacun d’eux, nous avons maintenu un seul objectif simple dès le début : rendre le produit aussi robuste que possible. Comme nous l’avons appris maintes et maintes fois, il n’y a pas de route plus rapide et plus fiable qu’une route ouverte : davantage de mains travaillant sur un même produit ne peuvent que l’améliorer. L’ouverture permet de prototyper un concept, ou de le tester dans ses toutes premières étapes. Qui plus est, les systèmes ouverts tolèrent mieux les défaillances – et attirent une communauté d’utilisateurs plus fidèles. Ils savent que la motivation première d’un système ouvert est l’excellence ; si la société essaie d’imposer un autre agenda, la communauté de développeurs le repérera immédiatement et se révoltera. En proposant un produit ouvert, la société renonce à la possibilité de faire autre chose que de le rendre meilleur pour l’utilisateur.

Les résultats parlent d’eux-mêmes. Si vous possédiez un smartphone en 2006, il y a des chances pour que « Blackberry » ou « Nokia » ait été inscrit dessus. Il y a encore trois ans, Android représentait à peine 5% du marché. Aujourd’hui nous avons dépassé les 51%, et il y a de fortes chances pour que votre smartphone ait été fabriqué par Samsung, HTC, Motorola ou un autre partenaire d’Android.

Android a même débarqué dans des secteurs que nous n’avions pas anticipés, tels que les téléviseurs, les voitures, les avions, et même les appareils domestiques. (Voyez Ouya, une nouvelle console de jeux vidéo basée sur Android. Sans un Android ouvert, ce genre d’innovation n’existerait pas). Il semble clair à présent que si vous vous investissez dans un système ouvert, vous vous engagez dans une compétition perpétuelle pour garder votre place d’innovateur principal.

La question de l’ouverture n’a pas été moins opérante pour le navigateur Chrome, qui s’est construit par dessus le projet open source Chromium. Aujourd’hui, Chrome est sept fois plus rapide qu’il ne l’était lorsqu’il a été lancé il y a à peine 4 ans, et le nouveau code est disponible pour le monde entier à mesure qu’il se développe. Travailler ainsi au grand jour rend plus difficile le fait d’avoir des agendas cachés ou quoi que ce soit de dissimulé ; faites mal les choses, et une communauté mondiale de développeurs vous repérera instantanément.

Faire de l’ouverture une tactique commerciale peut nécessiter de nouvelles compétences organisationnelles. La vitesse est primordiale, comme l’est la rigueur du processus de décision. Un écosystème ouvert encourage le bouillonnement d’idées. Or trouver de bonnes idées, c’est facile ; ce qui est difficile, c’est de choisir parmi elles. L’ouverture des données peut offrir un avantage concurrentiel important aux entreprises, mais seulement si elles sont correctement positionnées pour pouvoir en profiter. L’autre tactique — qui est notamment utilisée par Apple et nos équipes de recherche — est de garder le système plus fermé, et d’y exercer un contrôle total. Cette approche nécessite son propre jeu de compétences organisationnelles, au-delà de la vitesse d’exécution, puisque l’excellence du produit et son innovation prennent leur source uniquement en interne. Les deux approches peuvent évidemment toutes les deux réussir, mais selon notre expérience, quand il s’agit de construire une plateforme entière, l’ouverture est le chemin le plus sûr vers la réussite.

Heureusement, de plus en plus d’organisations perçoivent ce message. Dans Wikinomics, les auteurs Don Tapscott et Anthony D. Williams racontent l’histoire de Goldcorp, une entreprise de mines d’or de Toronto, qui semblait sur le déclin à la fin des années 90. Face à un marché en baisse, une foule de problèmes internes et ce qui semblait être un filon épuisé, le PDG Rob McEwen fit précisément l’inverse de ce que n’importe quel livre sur le business dirait : il commença par donner le peu que l’entreprise avait encore.

Plus exactement, il publia sur le site de l’entreprise 400 Mo d’informations concernant le site minier de 220 kilomètres carrés de Goldcorp. Plutôt que de conserver jalousement ses derniers lambeaux d’information propriétaire, il offrit un prix de 500,000$ à quiconque parviendrait à utiliser ces données, afin de trouver de l’or contenu dans le sol. Ce fut un énorme succès. Plus de 80% des cibles identifiées par le public donnèrent des quantités significatives d’or. Avec ce petit investissement initial, la société tira du sol l’équivalent plus de 3 milliards de dollars en or.

Évidemment, McEwen était seulement en train de s’accorder avec les principes profonds du mouvement open source. Dans les premiers jours confus de l’internet, une éthique d’universalité et d’égalitarisme s’était propagée. « Les jardins cernés de murs (NdT : Walled gardens), tout plaisants qu’ils soient, ne pourront jamais rivaliser en diversité, en richesse et en innovation avec le marché fou et palpitant du Web de l’autre côté du mur » a écrit Tim Berners-Lee, l’inventeur du World Wide Web. Google a toujours prospéré sur cette diversité, cette richesse et cette innovation. C’est ce qui nous a permis de lancer des créations comme Chrome et Android, et c’est ce qui a permis à une entreprise d’extraction vétuste d’éblouir le monde avec des succès similaires et pour des raisons similaires.

Aussi spectaculaire que soit l’histoire de Goldcorp, c’est seulement la partie émergée de l’iceberg. En effet, ce qui avait commencé comme un concept de geek au sein de communautés scientifiques s’est propagé dans tous les domaines, des affaires à la politique, de la santé à l’éducation et bien au-delà. Chez Google, nous envisageons un certain nombre de possibilités au-delà du secteur technique, où l’ouverture pourrait amener des progrès modestes et immenses à la fois.

L’éducation

De Stanford à la Corée, des universités et des enseignants du monde entier commencent à distribuer gratuitement des contenus éducatifs de très grande qualité sous licence libre. Qui plus est, des personnes vivant dans les endroits les plus reculés ont de plus en plus accès à ces contenus. La bande passante et la connectivité ont fait sauter de nombreuses barrières de la société en matière d’éducation.

Tout au bout d’un long chemin de terre à Bombay, un étudiant muni d’un téléphone peut maintenant suivre les cours du MIT au plus haut niveau. De façon tout aussi intéressante, ce même étudiant peut devenir professeur. Grâce à des organisations véritablement démocratiques, telles que la Khan Academy, une organisation à but non lucratif, qui propose en ligne plus de 3 000 cours en vidéo. Partout dans le monde des personnes peuvent à la fois disposer de et contribuer à une bibliothèque de ressources qui ne cesse de croître, depuis des leçons de physique jusqu’à des manuels de finance. Nous savons déjà à quel point l’éducation publique a transformé la société au cours du vingtième siècle. Les possibilités offertes par une éducation ouverte et en ligne semblent tout aussi illimitées.

Les gouvernements

Prétendre à la transparence gouvernementale est une chose mais des exemples comme celui du Canada avec sa Déclaration officielle de Gouvernement Ouvert, en sont une autre. Ce document reconnaît l’ouverture comme un état actif et non passif : il ne s’agit pas seulement de donner aux citoyens un libre accès aux données chaque fois que possible, mais bien de définir une « culture active de l’engagement » comme finalité de ces mesures.

Tandis que toujours plus de villes, de régions et de gouvernements fédéraux avancent dans cette direction, il y a tout lieu de croire que cela finira par payer financièrement (au moment où les données GPS ont été mises en libre accès public à la fin des années 80, par exemple, on estime que les services commerciaux qui en ont tiré parti ont contribué à hauteur de 67.6 milliards de dollars à la valeur économique des États-Unis). À l’inverse, on pourrait dire que lorsque le régime égyptien a verrouillé Internet en janvier 2011, cela a poussé les citoyens à descendre dans la rue pour avoir plus d’informations, et à venir grossir les foules de la place Tahrir. Il est ici probable que le retour à un système plus fermé ait accéléré la chute du gouvernement.

Le système de santé

PatientsLikeMe est un site de réseautage social de santé construit sur des bases de données ouvertes du Département de la Santé des États-Unis. Il ouvre la voie à d’autres initiatives, comme procurer aux patients des moyens de partager des informations et d’apprendre entre personnes souffrant de symptômes similaires. Les chercheurs pourraient également tirer profit de plus d’ouverture dans l’industrie.

L’ouverture des données sur la santé pourrait permettre à des études épidémiologiques à grande échelle de réaliser des percées importantes tout en mettant en place des garde-fous plus forts que jamais pour assurer au patient le respect de la confidentialité. En mettant à la disposition des chercheurs son registre des malformations congénitales, la Californie a permis aux médecins d’accéder à une mine d’informations relatives à l’impact des facteurs environnementaux sur la santé. Et bien sûr, Google Flu Trends a déjà prouvé sa pertinence pour analyser et prévoir l’arrivée d’un virus particulier, tout simplement en permettant que l’information soit partagée et rassemblée.

La science

Chercheurs, institutions, et agences de financement du monde entier commencent à prendre conscience qu’un meilleur partage et une meilleure collaboration sur les résultats de recherches scientifique peuvent mener à des recherches plus rapides, plus efficaces, de meilleure qualité et d’un meilleur impact général. En tant que commissaire européen, Neelie Kroes faisait récemment remarquer dans un discours sur la science et les politiques du libre en Europe, « les chercheurs, les ingénieurs et les petites entreprises ont besoin d’accéder aux résultats scientifiques rapidement et facilement. Si ce n’est pas possible, c’est mauvais pour les affaires ».

Un meilleur accès aux recherches scientifiques peut stimuler l’innovation dans le secteur privé et aider à résoudre des défis importants auxquels le monde doit faire face (les Google ‘Fusion Tables sont un outil que les scientifiques peuvent utiliser pour partager et collaborer sur des ensembles de donnés disparates). Pendant ce temps, l’ouverture dans le domaine scientifique signifie l’ouverture à de tout nouveaux participants. Après avoir échoué pendant plus d’une décennie à résoudre la structure d’une enzyme protéase provenant d’un virus ressemblant au SIDA, les scientifiques ont proposé le défi à la communauté des joueurs. En utilisant le jeu en ligne Foldit, les joueurs ont pu résoudre ce problème en trois semaines.

Les transports

En libérant les données des transports publics, les gouvernements permettent aux entrepreneurs de créer des applications basées sur ces données, et ainsi d’améliorer l’expérience des citoyens ; ces derniers peuvent également utiliser ces données ouvertes pour signaler des problèmes d’infrastructure. Chez Google, nous avons déjà pu observer comment cela fonctionne. Lorsque nous avons commencé à organiser les informations géographiques mondiales, nous avons constaté que, pour de nombreux endroits, il n’existait tout simplement pas de carte correcte. Nous avons donc créé MapMaker, un outil de cartographie participative qui permet à chacun de créer des annotations sur Google Maps. C’est avec cela qu’un réseau de citoyens cartographes est né, traçant en deux mois plus de 25 000 kilomètres de routes précédemment non cartographiées au Pakistan.

Les tendances technologiques convergentes sont maintenant sur le point de modifier, en fait elles ont déjà commencé à le faire, les domaines historiquement fermés, secrets et dormants. « L’avenir des gouvernements, c’est la transparence,» écrivais-je il y a un an, «L’avenir du commerce, c’est la symétrie de l’information. L’avenir de la culture, c’est la liberté. L’avenir de la science et de la médecine, c’est la collaboration. L’avenir du divertissement, c’est la participation. Chacun de ces avenirs dépend d’un Internet ouvert. »

Je mettrais juste un bémol. Étant donnés les changements radicaux auxquels nous avons assisté ces trois dernières années, le défi s’est déplacé. Nous devons viser plus loin même que l’Internet ouvert. Les institutions dans leur ensemble doivent continuer à adhérer à cette philosophie. Atteindre ces futurs objectifs ne sera pas chose facile. Mais je suis content de pouvoir dire que nous en sommes plus proches que jamais.

Crédit photo : John Martinez Pavliga (Creative Commons By)

Source :

- Les recherches en ligne sponsorisées dans Ubuntu ou l’histoire d’une polémique qui n’en finit pas (ZDNet)

- Cinquante nuances de Grey (Wikipédia)

Crédit : Simon Gee Giraudot (Creative Commons By-Sa)

S’en prendre conjointement à GNU/Linux et Microsoft, il fallait oser ! Mais en fait cela se tient et mérite peut-être débat.

Soyons plus précis. L’auteur jette ici son dévolu sur les deux nouvelles interfaces graphiques utilisateurs de l’actuelle distribution Ubuntu et de la prochaine version de Windows, à savoir respectivement Unity et Metro.

Il les met dans le même sac et y voit un changement poussé par les mêmes logiques. Un changement mais pas forcément une amélioration, surtout si l’on utilise son ordinateur pour travailler et non facebooker…

Nous avions cru comprendre que le fameux « Internet 2.0 » avait fait sauter la barrière entre les consommateurs et producteurs de contenus. Est-il possible ici qu’on les sépare à nouveau ?

Metro et Unity sont des adolescentes aux cheveux fluos

Metro and Unity Are Teenage Girls With Fluorescent Hair

Jeremy Morgan - 23 octobre 2012 - Blog personnel

(Traduction : Yuston, ehsavoie, Thomas Dutrion, tibs, Evpok, M0tty, goofy, Maïeul, Oliv, lgodard, Kronos, peupleLa, Gaëtan)

Vous vous souvenez de ces filles ni spécialement horribles, ni particulièrement attirantes, qui voulaient être le centre de toutes les attentions ? Elles faisaient des trucs fous comme se colorer les cheveux avec des couleurs criardes et portaient des piercings partout. Elles avaient souvent beaucoup de qualités mais ne le savaient pas. Ces filles pensaient qu’elles n’avaient rien de mieux à offrir, alors elles se promenaient avec des styles provocateurs pour attirer l’attention.

Voilà précisément pourquoi je pense que Microsoft et Ubuntu imposent leurs récentes modifications de l’interface graphique malgré les retours négatifs des utilisateurs. Ce besoin pressant d’apparaître différent et d’attirer l’attention va bien au-delà de la nécessité de satisfaire leurs utilisateurs.

Que ce soit parce que notre durée d’attention est beaucoup plus courte ou parce que les systèmes d’exploitation ont perdu de leur intérêt, le changement pour le changement semble être devenu la règle du jeu. Canonical et Microsoft secouent tout pour faire différent. Pas meilleur mais différent.

Metro et Unity : vous vous y ferez

L’interface Unity fut introduite avec la version 11.04 d’Ubuntu Linux, celle de Metro sera livrée avec Windows 8 et il semble bien que toutes deux suscitent la même réaction. Toutes les deux apportent des modifications radicales de l’interface utilisateur qui arrivent pour une bonne raison : le monde s’éloigne des ordinateurs de bureau. Le monde devient mobile, c’est incontestable.

Mais plusieurs d’entre nous, assez fous pour continuer à préférer un ordinateur de bureau ou un portable (ceux qui permettent de travailler vraiment) détestent ces interfaces. Si vous utilisez une tablette pour regarder des vidéos ou jouer à Angry Birds ça va. Si vous êtes architecte, infographiste, développeur de logiciel, animateur 3D ou quelque chose du genre, vous haïssez probablement ces nouvelles interfaces.

La réponse des deux camps est la même : l’avenir est déjà là alors autant vous faire à ces changements. Vous êtes libres de remplacer le bureau Ubuntu par l’une des nombreuses alternatives, et Windows 8 a un mode bureau mais il est radicalement différent. Que vous l’aimiez ou non le standard est défini et les plaintes tombent dans l’oreille d’un sourd.

Pourquoi tous ces changements ?

Demandez à n’importe qui chez Microsoft ou Canonical pourquoi ils changent nos repères et ils avanceront probablement des arguments marketing sur les tendances émergentes et la nécessité d’aller de l’avant et autres non-sens. Je pense que la vraie raison pour laquelle ils ont fait ces changements et les verrouillent est extrêmement simple : parce que c’est nouveau. C’est changer simplement pour le plaisir de changer parce que le bureau classique n’a pas changé depuis bien longtemps.

Le bouton Démarrer a toujours été présent depuis la sortie de Windows 95, Gnome et KDE sont apparus en 1997. Depuis cette époque, nous avons fait beaucoup de modifications et bien sûr d’améliorations, mais avec du recul, elles se ressemblent toutes. Des fenêtres, des menus, des messages similaires, et ce depuis la moitié des années 90. Vous voyez le problème ?

Ils ont seulement besoin de faire évoluer l’apparence. Les fonctionnalités d’un système d’exploitation ne changent pas radicalement avec le temps, si vous voulez restez dans le coup avec des cycles de renouvellement technologique rapides, vous devez faire bouger les choses. Vous devez être innovant, pas forcément meilleur. Eh vous avez vu ? — nous n’avons plus de bouton Démarrer.

Qu’est ce qui se cache derrière ?

Vous pouvez donc vous demander : sont-ils juste en train de mettre du rouge à lèvre à un cochon ? La réponse pour les deux systèmes est non. En réalité, ils sont tous les deux meilleurs que ce qu’ils n’ont jamais été.

Ubuntu Linux est un système d’exploitation de premier ordre qui devient plus rapide, plus stable et qui prend en charge plus de matériel que jamais. La pile logicielle est super, la gestion des paquets et la sécurité… tout cela est hautement apprécié.

Windows 8 a également été remanié et cela pourrait bien être leur meilleur système d’exploitation à ce jour. Des avancées technologiques comme l’UEFI ont été introduites : un pré-système d’exploitation, le diagnostic à distance, une option « live USB », un temps de démarrage plus rapide et le support de l’USB 3.0, pour n’en citer que quelques unes. Il y a eu des améliorations au niveau du noyau et d’autres modifications qui le font tourner plus vite que Windows7 sur le même matériel. Du point de vue technique, il n’est pas à la traîne.

Ces deux systèmes d’exploitation sont au top de leur niveau, alors pourquoi développer ces interfaces flashy pour attirer l’attention ? Pourquoi ne peuvent-ils pas vendre ces systèmes d’exploitation en mettant en avant leurs propres mérites ?

Parce que plus personne ne se soucie de ces trucs-là.

La cible marketing

En tant qu’utilisateur régulier d’Ubuntu, j’aime bien lancer une petite pique par-ci par-là à Jono Bacon et sa bande, surtout lorsqu’on en vient à Unity. Je l’ai déjà dit et je le redirai : si je veux un système Ubuntu vraiment stable, j’utilise la version 10.04 et lui compile un noyau 3.6. Ça marche, tout simplement, et l’interface est facile à utiliser pour ceux qui en ont besoin. Pour mon usage, Ubuntu a atteint un sommet à la version 10.04, et moi, comme d’autres, l’avons fait savoir.

La réponse qu’on me ressort tout le temps : « tu n’es pas notre cible de toute façon ». Je le comprends et je sais que c’est vrai. Canonical ne cible plus les hackers maintenant, et Microsoft ne l’a jamais fait. Ils veulent tous les deux répondre à l’appel du marché grand public.

Quand les versions bêta d’Unity et Metro sont sorties, les hackers ont été les premiers à s’en plaindre bruyamment, mais ils ont été ignorés. Mais le plus gros problème que je vois, c’est que pratiquement tous les utilisateurs semblent les détester.

Vous ciblez Monsieur Tout-le-monde, mais c’est ça le problème : Monsieur Tout-le-monde s’adapte encore moins facilement à des interfaces déroutantes. Un geek va faire de son mieux pour apprendre quelque chose de nouveau mais si un utilisateur moyen est dérouté par une interface, il va simplement l’éviter.

Le client a toujours raison, mais on s’en fiche

Unity est sorti depuis un moment maintenant, et il y a certainement des personnes qui s’y sont habituées, et d’autres qui vont même jusqu’à le le préfèrer. Quoi qu’il en soit, la plupart des personnes avec qui j’en ai parlé et 90% des commentaires que j’ai vus sur Internet suggèrent que Unity est un flop. Windows 8 n’est pas en test depuis suffisamment longtemps mais j’ai pu voir que ça partait déjà dans la même direction.

Allez vous donc rester sur votre mauvaise décision même si votre public ne l’aime pas ? Dans le cas de Canonical/Ubuntu la réponse est oui. Il semblerait que Microsoft suive le même chemin. Ils ont tous les deux une position similaire : on sait ce qui est bon pour vous et on va vous forcer à l’utiliser. Si vous ne l’aimez pas, vous allez vous habituer à l’utiliser. Ne soyez pas effrayé par le changement, ne vivez pas dans le passé.

Cette attitude arrogante est partagée par les deux camps, et c’est un pari énorme d’abandonner certains bons concepts et bonnes expériences utilisateur connues dans le but de faire différent.

Conclusion

Si vous lisez ce blog, il y a de fortes chances que vous ne correspondiez pas au type d’utilisateur que souhaitent Microsoft ou Canonical. Ils mettent en place une nouvelle interface tape-à-l’œil pour ce nouveau type d’utilisateurs. Ils veulent des gens qui consomment du contenu, pas des gens qui en produisent. La raison en est assez évidente : il y a beaucoup plus de consommateurs que de producteurs de contenus. Si vous produisez quelque chose, le système d’exploitation sera simplement un outil pour faire démarrer votre ordinateur et fonctionner votre programme. Vous n’avez pas besoin de plus, et mettre à jour tout votre système tous les ans deviendrait bête et inutile.

Si vous êtes un consommateur, vous voulez des mises à jour même si elles ne veulent pas vraiment dire grand-chose. S’ils fournissent une espèce de nouvelle fonctionnalité pour votre appareil, vous installerez joyeusement un nouveau système d’exploitation tous les six mois. Vous voulez du neuf et du tape-à-l’œil, pas du vieux et terne. Vous voulez qu’on puisse voir à dix mètres de distance que votre système est différent des autres. Si vous voulez de la stabilité et des recettes qui ont fait leurs preuves, vous prendrez un produit Apple. Voilà exactement sur quoi comptent Microsoft comme Canonical, et ils vont parier leur avenir là-dessus.

Crédit photos : LGEPR et GrowDigital (Creative Commons By)

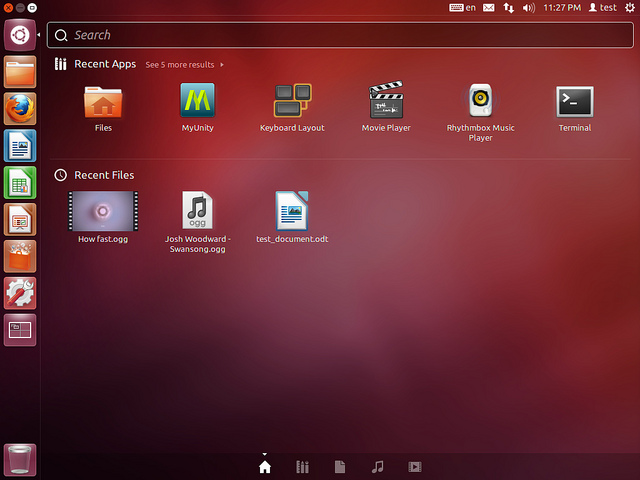

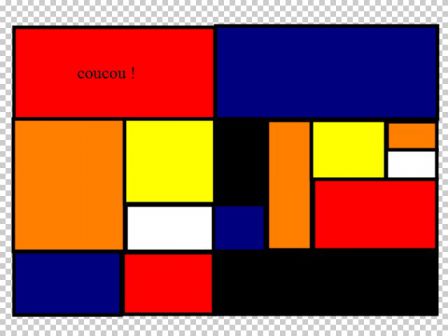

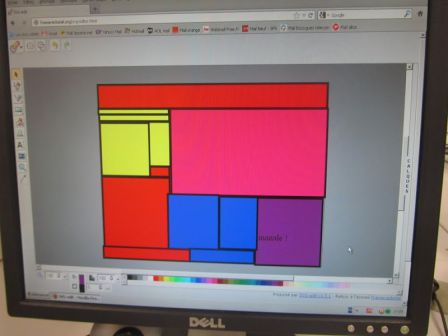

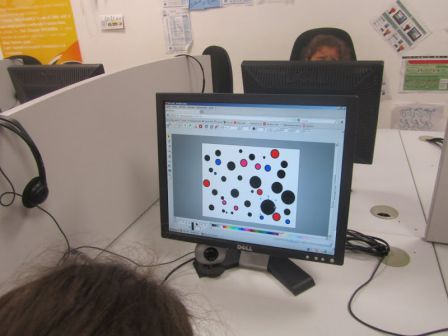

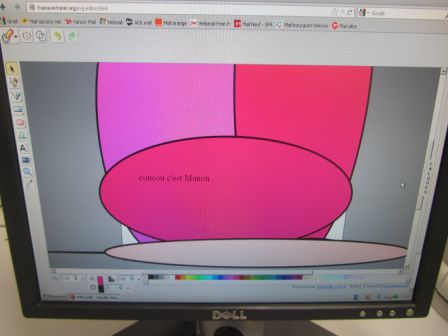

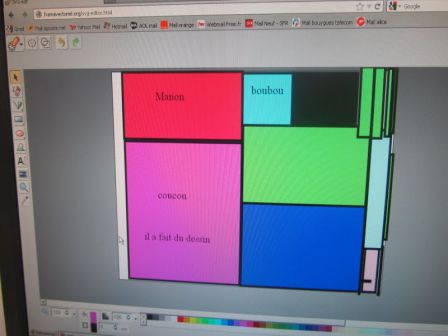

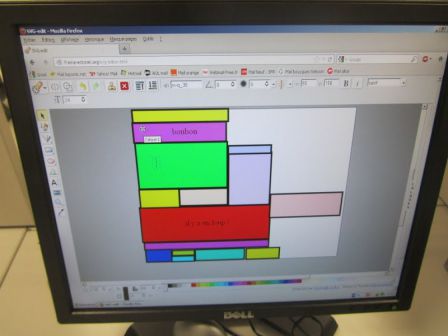

Nous avons annoncé la sortie du projet Framavectoriel il y a à peine quelques heures.

Et l’on nous a gentiment signalé par Twitter qu’on l’utilisait déjà avec des enfants dans un espace public numérique corse !

Il s’agit de l’espace Cyber-base emploi / P@m de Folelli dans la cadre d’un CLAE (Centre de Loisirs Associé à l’Ecole).

Nous en sommes ravis et félicitations à tous ces petits Mondrian en herbe :)

« L’affaire OpenJustitia » qui se déroule actuellement en Suisse est un cas très intéressant.

Comme on peut le lire sur le site du projet, OpenJustitia est « un ensemble de logiciels spécifiques pour les tribunaux. Le Tribunal fédéral a développé ces derniers de sa propre main et les a personnalisés à ses propres besoins. OpenJustitia permet notamment une recherche efficace dans les décisions du tribunal. »

Il a donc été développé en interne et, comme son nom le suggère, il est libre (sous lience GNU GPL v3) et a d’ailleurs reçu un prix dernièrement aux CH Open Source Awards 2012.

Nous voici donc en présence d’un logiciel libre métier développé et mutualisé par l’administration. D’ailleurs le canton de Vaud a d’ores et déjà signé une convention de collaboration avec le Tribunal fédéral.

C’est exactement ce que prône en France une association comme l’ADULLACT avec la fameuse citation de son président François Elie : « l’argent public ne doit payer qu’une fois ».

Sauf qu’un parti politique (et derrière lui un éditeur de logiciels propriétaires) ne l’entendent pas de cette oreille, comme nous le rapporte l’ICTjournal.

Pour ce qui concerne l’éditeur, c’est (plus que) maladroit mais (malheureusement) compréhensible :

L’entreprise bernoise Weblaw, éditrice de logiciels de tribunaux propriétaires, estime que le Tribunal fédéral et sa solution font de l’ombre aux fournisseurs privés de logiciels. Le Tribunal fédéral doit-il s’occuper de droit ou de logiciels ?

Mais ce qui l’est moins c’est de voir l’UDC lui emboîter le pas et ne pas saisir l’intérêt, voire le bon sens, à utiliser du logiciel libre dans les institutions publiques :

Le Conseil fédéral doit examiner, à la demande de l’UDC, si le Tribunal fédéral a le droit de d’agir comme fournisseur du logiciel open-source Openjustitia. En agissant de la sorte, ce dernier délivrerait des services non liés à ses compétences judiciaires.

Il est « totalement absurde » que le Tribunal fédéral fonctionne comme distributeur de logiciels, a déclaré Martin Baltisser, secrétaire général de l’UDC. Selon lui, d’une part le Tribunal fédéral n’aurait aucun intérêt prépondérant à agir en tant que fournisseur de logiciels, d’autre part il serait également dépourvu de base légale. Selon la Constitution et la Loi sur les finances de la Confédération, l’Etat ne peut intervenir au niveau commercial uniquement s’il n’existe pas d’offre privée et qu’une loi l’y autorise. Le Tribunal fédéral réplique qu’il ne réalise «aucun service commercial», comme le projet est open source, le logiciel est mis à disposition gratuitement.

Comme on peut le voir ci-dessous, on en a même parlé le 20 octobre dernier à la RTS mais, triste classique, en occultant complètement le libre pour n’évoquer que le gratuit :

D’autres voix se font heureusement entendre, comme celle de l’élu des Verts François Marthaler qui conteste, à juste titre et avec vigueur, cette demande de clarification de l’UDC sur son blog :

Je veux bien croire que la situation économique de Weblaw soit menacée. Mais je ne peux pas imaginer que les pouvoirs publics se trouvent empêchés de développer des solutions plus performantes et surtout moins onéreuses, dans l’intérêt de tous les contribuables et du bon fonctionnement de l’Etat. Plus encore que les coûts du développement initial du logiciel, ce qui est en jeu, c’est la maintenance et l’évolution du système au profit de l’administration, des justiciables et, finalement, des contribuables.

Sans le dire, Weblaw s’attaque au modèle économique des logiciels libres (open source). Un modèle dans lequel le prestataire ne peut prétendre encaisser plus que la réelle valeur ajoutée au produit et pas une rente de situation. Que se serait-il passé si une société privée avait conçu le logiciel OpenJustitia et avait décidé de le mettre sous licence GNU/GPL ? Rien ! L’UDC n’aurait pas pu invoquer le « moins d’Etat » pour défendre les intérêts privés de cette petite société.

Espérons que comme le dit le dicton : les chiens aboient, la caravane passe…

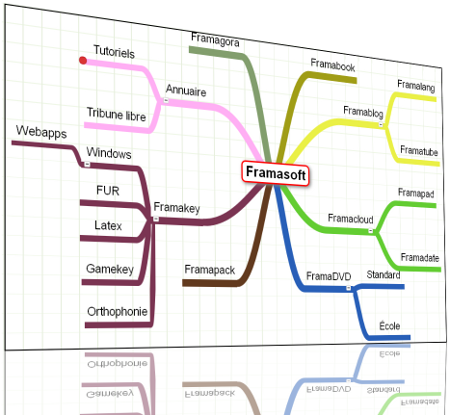

Dans la famille « les libres et pratiques services Web proposés par Framasoft » qui ne demandent pas d’inscription, on a : le traitement de texte collaboratif (Framapad), le tableur collaboratif (Framacalc), l’équivalent d’un Doodle mais en libre (Framadate) et un tout récent éditeur de cartes mentales (Framindmap).

Et pourquoi pas aussi, tant qu’on y est, un outil d’édition d’images en ligne ?

Il arrive, il arrive et il s’appelle Framavectoriel !

Attention, ce n’est pas demain la veille qu’on trouvera un équivalent de The Gimp à même votre navigateur, mais on vous propose néanmoins la version francisée de svg-edit, libre application certes modeste mais non dénuée déjà de nombreuses fonctions et qui saura trouver son utilité dans des cas simples ou des situation de formation (nous ne saurons trop vous suggérer de mettre vos enfants dessus plutôt que sur l’abominable Paint).

En fait ce n’est pas la comparaison avec The Gimp qui est judicieuse ici mais plutôt Inkscape (dont il constitue une excellente initiation). En effet l’atout principal de Framavectoriel c’est de proposer de travailler au puissant format libre et ouvert SVG.

Parce que certains l’ignorent encore mais lorsque vous êtes en situation de création graphique et non de retouche photo il est alors bien plus pertinent d’utiliser des images vectorielles et non matricielles, a fortiori si le format est libre.

Et c’est aussi parce que nous avons envie de participer à pousser ce format que nous avons décidé de mettre en ligne ce service en le baptisant ainsi.

-> Découvrir et utiliser Framavectoriel

PS : Oui, on vous le coup à chaque fois désormais, mais si vous avez le temps et les moyens d’un petit soutien sonnant et trébuchant pour nous remercier du service (si service il y a), ça nous aiderait à poursuivre sereinement l’aventure car nous n’avons qu’une visibilité de quelques mois actuellement.

Windows 8, le nouveau système d’exploitation de Microsoft, qui sera le même pour PC, tablette et smartphone, devrait être lancé officiellement le 26 octobre, et on peut compter sur le puissant marketing de la multinationale pour nous abreuver d’images cool, avec des doigts qui caressent une interface tactile en tuiles sur un bureau attrayant. C’est certain, l’interface entièrement rénovée sera plus au goût du jour, maintenant que la vaste diffusion des appareils mobiles nous a accoutumés à d’autres gestes que cliquer sur des icônes…

Le libristes habitués aux versions successives plus ou moins buguées de Windows (et celle-ci promet déjà de l’être) hausseront sans doute les épaules et retourneront à leur Debian. Ils auront peut-être tort si l’on en croit Casey Muratori, qui se demande si l’impact du nouveau système ne pourrait pas être aussi décisif pour l’informatique grand public que la sortie de Windows 3.0.

En effet, derrière ce qu’on ne manquera pas de nous vendre comme un progrès, c’est une véritable régression qui va s’opérer : tous les logiciels qui tourneront avec le nouveau système devront passer obligatoirement par le Windows Store, Microsoft exercera donc un contrôle total sur son écosystème logiciel.

De plus, la compatibilité maintenue de l’ancienne interface avec la nouvelle, si elle semble assurée dans une première étape, pourrait à terme en signer la disparition pure et simple, comme le souligne l’auteur de l’article ci-dessous, qui établit judicieusement un rappel historique : souvenez-vous de la manière dont MS-DOS a progressivement été effacé du paysage après une brève période de coexistence avec Windows 3.0. Euh oui ça ne rappellera rien aux plus jeunes, mais prendre un peu de recul est ici pertinent.

La menace de Windows 8 c’est d’abord d’imposer un système fermé à tous les développeurs et bien sûr à tous les consommateurs. Mais Casey Muratori se demande in fine si la première victime ne sera pas Microsoft lui-même, tant le virage stratégique qu’il opère risque de lui coûter ses principaux soutiens. La bataille des systèmes d’exploitation est engagée, qui en sortira indemne ?

Remarque : Nous n’avons pas traduit les deux appendices qui figurent en bas de l’article d’origine mais nous serions ravis de trouver des volontaires prêts à compléter cela avec nous sur le framapad de travail.

Les vingt ans à venir

Casey Muratori - 8 octobre 2012 - MollyRocket.com

(Traduction : Genevois, Maïeul, KoS, BlackEco, mib_6025, Geekandco, FredB, goofy, Quentin)

Voici pourquoi le modèle de distribution fermé de Windows 8 doit être remis en cause dans l’intérêt des développeurs, des consommateurs et même de Microsoft lui-même.

Pour la première fois dans l’histoire du PC, Microsoft s’apprête à diffuser un nouvel écosystème Windows dont il sera le seul et unique fournisseur de logiciels. Si vous achetez Windows 8, le seul endroit où vous pourrez télécharger des logiciels qui s’intègreront à la nouvelle interface de système, ce sera le Windows Store officiel. Microsoft exercera un contrôle total sur les logiciels autorisés ou non sur son système d’exploitation.

Microsoft a déclaré que les applications destinées à l’interface plus ancienne du bureau ne seraient pas impactées par cette nouvelle politique. Tant qu’ils utiliseront seulement des applications qui tournent sur le bureau classique, les utilisateurs auront encore la possibilité d’acheter, vendre, développer et distribuer des logiciels sans que Microsoft ne s’en mêle. Beaucoup d’utilisateurs de Windows ont compris cette déclaration comme une assurance que le modèle ouvert de distribution dont ils bénéficient aujourd’hui serait encore valide dans les futures versions de Windows. Du coup beaucoup moins de gens ont réagi au problème posé par Windows 8 que si la déclaration avait été comprise différemment.