Framablog - Archives (novembre 2014)

Issu du monde éducatif, Framasoft est un réseau de sites web collaboratifs à géométrie variable dont le dénominateur commun est le logiciel libre.

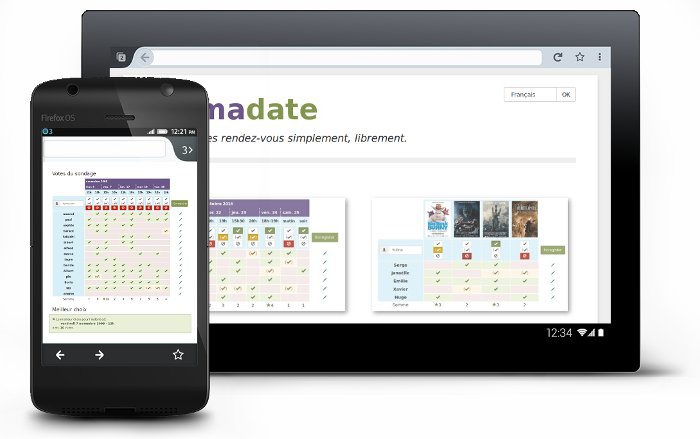

Framadate est, avec Framapad, l’un de nos services les plus utilisés. Cette alternative libre à Doodle vous permet de créer des sondages et vous aide ainsi à planifier des rendez-vous ou prendre des décisions en recueillant l’avis des participants.

En temps normal Framasoft ne développe pas de logiciel : ce n’est pas notre motivation principale et nous ne sommes pas des programmeurs (enfin… pas tous).

Lorsque nous avions décidé de forker Studs [1], le logiciel nous paraissait simple et facile à maintenir.

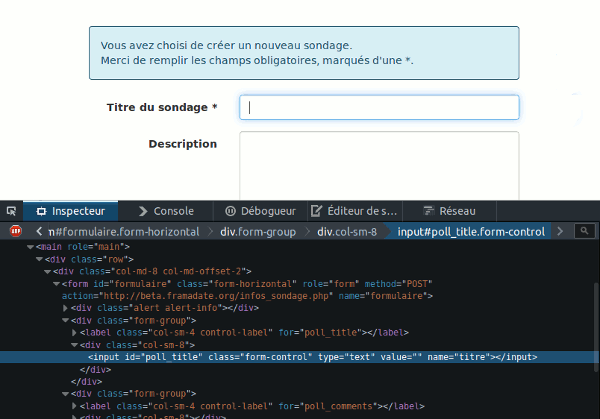

Techniquement, il ne s’agit que de formulaires et tableaux en HTML, un peu de PHP pour traiter les données et une base MySQL pour les stocker. Pourtant, malgré cette simplicité, de nombreuses erreurs de conception le rendaient totalement inutilisable aux personnes en situation de handicap… Une fois n’est pas coutume, on a donc mis les mains dans le code.

Accessibilité

En avril, Armony Altinier, présidente de l’association Liberté 0 et spécialiste en accessibilité numérique, s’est penchée sur le code de Framadate pour nous proposer quelques améliorations qui auraient pu être déployées rapidement et profiter à tous.

Il s’agissait de structurer l’information dans les pages, rendre l’interface entièrement navigable au clavier, améliorer les contrastes, proposer des alternatives textuelles aux images qui puissent être lues par les lecteurs d’écran ; et, de manière générale, rendre les pages conformes au standard HTML[2].

Mais voilà, certaines modifications nous contraignaient à y regarder d’un peu plus prêt pour être mises en œuvre. Nous en avons donc profité pour clarifier le code, améliorer l’ergonomie et ajouter quelques fonctionnalités qui nous étaient très souvent demandées.

Ergonomie

Pour nous faciliter la tâche, nous avons adopté le framework libre Twitter Bootstrap, ce qui nous a permis de rentre aussitôt Framadate utilisable sur des interfaces mobiles et d’homogénéiser le design.

En tenant compte de nombreux retours d’utilisation, nous avons également amélioré le parcours de création de sondage. Les étapes sont à présent clairement définies, les messages d’aide à la saisie sont mis en évidence et le parcours se termine sur la page d’administration du sondage de manière à ce que vous puissiez gérer votre sondage même si vous n’avez pas reçu le lien par courriel.

Auparavant, les options proposées dans cette page n’étaient pas très visibles (de nombreuses personnes ne trouvaient tout simplement pas le bouton de suppression du sondage par exemple), elles sont maintenant toutes accessibles depuis le cadre de présentation en haut.

Fonctionnalités

Parmi les nouveautés, vous aurez maintenant la possibilité d’exporter les résultats des sondages dans un fichier .csv pour ainsi les exploiter dans un tableur (libre de préférence ;-) ).

Il vous sera également possible de verrouiller votre sondage, remettre à zéro les votes et commentaires, proposer des images ou des liens parmi les choix possibles…

Et surtout, vous pourrez désormais offrir à vos sondés la possibilité d’exprimer des choix moins tranchés avec le vote « Oui, si nécessaire » !

Et la suite ?

Comme nous le disions en introduction, Framasoft n’a pas vocation à développer du logiciel. C’est pourquoi nous avons besoin de développeurs pour améliorer encore Framadate.

Par exemple, la possibilité de valider des votes par courriel serait une fonctionnalité très pertinente que nous ne proposons pas. De plus, un bon programmeur verra rapidement que le code a besoin d’être nettoyé (angliciser le code, restructurer, simplifier).

Et comme il n’y a pas que les codeurs dans la vie, des traducteurs sont les bienvenus pour finaliser les versions allemandes et espagnoles ou traduire dans d’autres langues. Et pour les amoureux de la langue de Stallman, la traduction du tutoriel d’installation n’attend que vous ;-)

Dégooglisons

La mise à jour de Framadate s’inscrit dans la vaste campagne que nous avons lancée voici quelques semaines et planifiée sur plusieurs années : « Dégooglisons Internet ». Notre objectif est de vous proposer des services libres, éthiques, décentralisés et solidaires contrairement à ce que font les géants du web que sont Google, Apple, Facebook, Amazon ou Microsoft.

Nous n’avons pas la prétention de remplacer ces géants mais bien de proposer des alternatives libres que chacun peut utiliser l’esprit tranquille grâce à la charte mise en place.

Si vous préférez cultiver votre propre jardin, on vous encourage à planter vos propres graines sur vos serveurs grâce au tutoriel proposé sur Framacloud.[3]

Comme annoncé, nous avons depuis le lancement de la campagne déjà mis en place une alternative au réseau social Facebook avec Framasphère ainsi qu’une mise à jour de Framindmap.

Et ce n’est pas fini ! La fin de l’année promet d’être riche avec, notamment la sortie d’un moteur de recherche !

Mais tout ceci ne sera possible qu’avec votre soutien : diffusion de l’information, dons déductibles des impôts…

Notes

[1] Logiciel initialement développé pour les besoins internes de l’université de Strasbourg sur lequel s’appuie Framadate

[2] Pour visualiser les modifications effectuées, nous avons sauvegardé une copie de Framadate avant mise en conformité avec les normes d’accessibilité, donc après modifications.

[3] À noter que pour les utilisateurs de YunoHost (un logiciel conçu pour simplifier l’auto-hébergement), Valentin Grimaud a mis en place un paquet Framadate.

Les algorithmes[1] ne sont guère qu’une série d’instructions pas-à-pas généralement exécutées par un programme sur une machine. Cependant leur complexité et leur opacité pour le commun des mortels sont redoutables, et bien plus encore leur omniprésence dans tous les compartiments de notre vie, y compris la plus intime. Si le code fait la loi, c’est justement parce que les algorithmes sont à la fois puissants, invasifs et sont devenus aujourd’hui indispensables.

L’article ci-dessous ne met pas l’accent sur les nombreux domaines où nous utilisons des algorithmes sans en avoir conscience, il pointe davantage les risques et menaces qu’ils représentent lorsque ce sont les algorithmes qui déterminent notre existence, à travers quelques exemples parmi bien d’autres.

Il pose également l’intéressante question de la responsabilité de ceux qui élaborent les algorithmes. Suffira-t-il d’un sympathique engagement solennel à la manière de celui des acteurs du Web ?

Les codeurs dont les algos contrôlent nos vies, qui les contrôle ? Pouvons-nous avoir un droit de regard sur les algorithmes qui désormais menacent de régir nos vies ?

Source : article du magazine Wired Algorithms are great and all, but can also ruin our lives

Les algorithmes sont formidables mais peuvent aussi ruiner des vies

Extrait de l’essai (en anglais) The Formula: How Algorithms Solve All Our Problems—and Create More par Luke Dormehl

Traduction Framalang : Wan, r0u, goofy, Sphinx, sinma, Omegax, ylluss, audionuma

Le 5 avril 2011, John Gass, 41 ans, a reçu un courrier du service d’enregistrement des véhicules motorisés (Registry of Motor Vehicles ou RMV) de l’État du Massachusetts. La lettre informait M. Gass que son permis de conduire avait été annulé, qu’il lui était désormais interdit de conduire et que cela prenait effet immédiatement. Le seul problème, c’est qu’en bon conducteur n’ayant pas commis d’infraction grave au code de la route depuis des années, M. Gass n’avait aucune idée du motif de ce courrier.

Après plusieurs appels téléphoniques frénétiques, suivis par une entrevue avec les fonctionnaires du service, il en a appris la raison : son image avait été automatiquement signalée par un algorithme de reconnaissance faciale conçu pour parcourir une base de données de millions de permis de conduire de l’État, à la recherche de possibles fausses identités criminelles. L’algorithme avait déterminé que Gass ressemblait suffisamment à un autre conducteur du Massachusetts pour présumer d’une usurpation d’identité, d’où le courrier automatisé du RMV.

Les employés du RMV se sont montrés peu compréhensifs, affirmant qu’il revenait à l’individu accusé de prouver son identité en cas d’erreur quelconque et faisant valoir que les avantages de la protection du public l’emportaient largement sur les désagréments subis par les quelques victimes d’une accusation infondée.

John Gass est loin d’être la seule victime de ces erreurs d’algorithmes. En 2007, un bogue dans le nouveau système informatique du Département des services de santé de Californie a automatiquement mis fin aux allocations de milliers de personnes handicapées et de personnes âgées à bas revenus. Leurs frais d’assurance maladie n’étant plus payés, ces citoyens se sont alors retrouvés sans couverture médicale.

Là où le système précédent aurait notifié les personnes concernées qu’elles n’étaient plus considérées comme éligibles aux allocations en leur envoyant un courrier, le logiciel maintenant opérationnel, CalWIN, a été conçu pour les interrompre sans avertissement, à moins de se connecter soi-même et d’empêcher que cela n’arrive. Résultat : un grand nombre de ceux dont les frais n’étaient plus pris en charge ne s’en sont pas rendu compte avant de recevoir des factures médicales salées. Encore beaucoup n’avaient-ils pas pas les compétences nécessaires en anglais pour naviguer dans le système de santé en ligne et trouver ce qui allait de travers.

Des failles similaires sont à l’origine de la radiation de votants des listes électorales sans notification, de petites entreprises considérées à tort comme inéligibles aux contrats gouvernementaux, et d’individus identifiés par erreur comme « parents mauvais payeurs ». Comme exemple notable de ce dernier cas, Walter Vollmer, mécanicien de 56 ans, a été ciblé à tort par le Service fédéral de localisation des parents, et s’est vu envoyer une facture de pension alimentaire à hauteur de 206 000 $. L’épouse de M. Vollmer, 32 ans, a par la suite montré des tendances suicidaires, persuadée que son mari avait eu une vie cachée pendant la majeure partie de leur mariage.

Une possibilité tout aussi alarmante : qu’un algorithme puisse ficher par erreur un individu comme terroriste. Un sort qui attend chaque semaine environ 1500 voyageurs malchanceux qui prennent l’avion. Parmi les victimes passées de ces erreurs de corrélation de données, on retrouve d’anciens généraux de l’armée, un garçon de quatre ans, ainsi qu’un pilote d‘American Airlines, qui a été détenu 80 fois au cours d’une même année.

Beaucoup de ces problèmes sont dus aux nouveaux rôles joués par les algorithmes dans l’application de la loi. Les budgets réduits menant à des réductions de personnel, les systèmes automatisés, auparavant de simples instruments administratifs, sont maintenant des décideurs à part entière.

Dans nombre de cas, le problème est plus vaste que la simple recherche d’un bon algorithme pour une tâche donnée. Il touche à la croyance problématique selon laquelle toutes les tâches possibles et imaginables peuvent être automatisées. Prenez par exemple l’extraction de données, utilisée pour découvrir les complots terroristes : de telles attaques sont statistiquement rares et ne se conforment pas à un profil bien défini comme, par exemple, les achats sur Amazon. Les voyageurs finissent par abandonner une grande partie de leur vie privée au profit des algorithmes d’extraction de données, avec peu de résultats, si ce n’est des faux-positifs. Comme le note Bruce Schneier, le célèbre expert en sécurité informatique :

Chercher des complots terroristes… c’est comme chercher une aiguille dans une botte de foin, ce n’est pas en accumulant davantage de foin sur le tas qu’on va rendre le problème plus facile à résoudre. Nous ferions bien mieux de laisser les personnes chargées d’enquêtes sur de possibles complots prendre la main sur les ordinateurs, plutôt que de laisser les ordinateurs faire le travail et les laisser décider sur qui l’on doit enquêter.

Bien qu’il soit clair qu’un sujet aussi brûlant que le terrorisme est un candidat parfait pour ce type de solutions, le problème central se résume encore une fois à cette promesse fantomatique de l’objectivité des algorithmes. « Nous sommes tous absolument effrayés par la subjectivité et l’inconstance du comportement humain », explique Danielle Citron, professeur de droit à l’Université du Maryland. « Et à l’inverse, nous manifestons une confiance excessive pour tout ce que peuvent accomplir les ordinateurs ».

Le professeur Citron suggère que l’erreur vient de ce nous « faisons confiance aux algorithmes, parce que nous les percevons comme objectifs, alors qu’en réalité ce sont des humains qui les conçoivent, et peuvent ainsi leur inculquer toutes sortes de préjugés et d’opinions ». Autrement dit, un algorithme informatique a beau être impartial dans son exécution, cela ne veut pas dire qu’il n’a pas de préjugés codés à l’intérieur.

Ces erreurs de jugement, implicites ou explicites, peuvent être causées par un ou deux programmeurs, mais aussi par des difficultés d’ordre technique. Par exemple, les algorithmes utilisés dans la reconnaissance faciale avaient par le passé de meilleurs taux de réussite pour les hommes que pour les femmes, et meilleurs pour les personnes de couleur que pour les Blancs.

Ce n’est pas par préjugé délibéré qu’un algorithme ciblera plus d’hommes afro-américains que de femmes blanches, mais cela ne change rien au résultat. De tels biais peuvent aussi venir de combinaisons plus abstraites, enfouies dans le chaos des corrélations de jeux de données.

Prenez par exemple l’histoire de l’afro-américaine Latanya Sweeney, docteure de l’Université d’Harvard. En effectuant des recherches sur Google, elle fut choquée de découvrir que les résultats de ses recherches étaient accompagnés de publicités demandant : « Avez-vous déjà été arrêté(e) ? ». Ces annonces n’apparaissaient pas pour ses collègues blancs. Sweeney se lança alors dans une étude, démontrant que les outils d’apprentissage automatique utilisés par Google étaient incidemment racistes, en associant plus souvent des noms donnés à des personnes noires avec des publicités ayant trait aux rapports d’arrestation.

Le système de recommandation de Google Play révèle un problème similaire : il suggère aux utilisateurs qui téléchargent Grindr, un outil de réseautage social basé sur la localisation pour les gays, de télécharger également une application qui assure le suivi géolocalisé des délinquants sexuels. Au vu de ces deux cas, devons-nous conclure que les algorithmes ont fait une erreur, ou plutôt qu’ils sont révélateurs des préjugés inhérents à leurs concepteurs ? Ou, ce qui semble plus probable, ne seraient-ils pas révélateurs d’associations inappropriées et à grande échelle entre — dans le premier cas — les personnes noires et le comportement criminel, et — dans le deuxième cas — l’homosexualité et les agressions sexuelles ?

Peu importe la raison, peu importe la façon répréhensible dont ces corrélations codifiées peuvent exister, elles révèlent une autre face de la culture algorithmique. Quand un seul individu fait explicitement une erreur de jugement, il ne peut jamais affecter qu’un nombre fini de personnes. Un algorithme, quant à lui, a le potentiel d’influer sur un nombre de vies exponentiellement plus grand.

Deux articles en français sur le même sujet :

Note

[1] Pour une définition plus élaborée voir Qu’est-ce qu’un algorithme

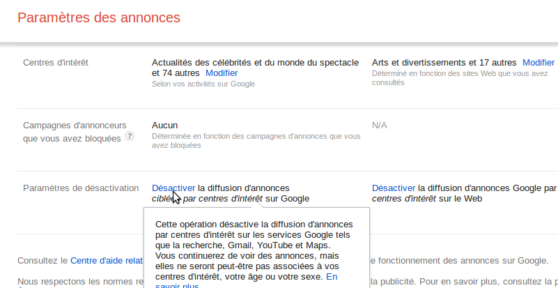

Le bref article traduit ci-dessous ne fait que réunir et rassembler commodément des liens vers des ressources qui ne sont nullement secrètes. C’est au contraire tout à fait ouvertement que Google met à votre disposition ce qu’il sait de vous, il vous suffit de rechercher dans les paramètres de votre compte Google (mmmh car vous en avez encore un n’est-ce pas ?).

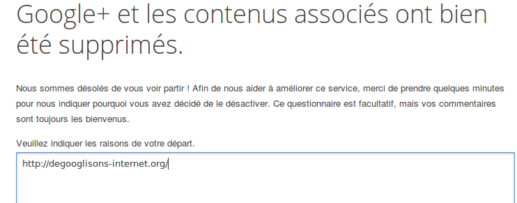

Vous vous demandez sans doute alors pourquoi un article du Framablog vous invite à cliquer sur les liens… Google, alors que nous sommes engagés dans une campagne à long terme pour vous inciter à vous déprendre de son emprise. Disons que c’est une façon rapide et frappante de prendre conscience de ce que nous sommes devenus pour cette entreprise : des données monnayables. C’est aussi une façon de découvrir que non seulement vous pouvez désactiver les fonctionnalités les plus intrusives, mais que vous pouvez même récupérer toutes les données que vous avez généreusement données à Google (voyez le 6e lien) avant de supprimer votre compte !

Faites connaître autour de vous ces quelques liens, en particulier à ceux qui par simple ignorance ou par indifférence ne voient pas pourquoi ils devraient s’efforcer de renoncer peu à peu à Google, à ses pompes et à ses œuvres (oui je sais, Amazon, Apple, Facebook et d’autres sont sur les rangs aussi mais ils ne perdent rien pour attendre).

Article original sur le blog de Cloudfender 6 links that will show you what Google knows about you

Six liens qui vont vous montrer ce que Google sait de vous

Vous voulez savoir tout ce que Google sait sur vous ? Voici 6 liens qui vont vous montrer certaines des données que Google possède sur vous.

1. Découvrez comment Google vous voit

Google tente de créer un profil de base de vous, selon votre âge, votre sexe, vos centres d’intérêt. C’est avec ces données que Google vous « sert » des annonces pertinentes. Vous pouvez examiner la façon dont Google vous voit ici :

https://www.google.com/ads/preferences/

2. Découvrez l’historique de votre géolocalisation

Si vous utilisez Android, votre appareil mobile peut envoyer à Google des informations de géolocalisation ainsi que de vitesse d’accès. Vous pouvez voir l’historique complet de vos « positions » et les exporter ici :

https://maps.google.com/locationhistory

3. Découvrez l’intégralité de votre historique de recherches Google

Google enregistre jusqu’à la moindre recherche que vous faites. Par-dessus le marché, Google enregistre toutes les pubs Google sur lesquelles vous avez cliqué. L’historique est à votre disposition ici :

4. Découvrez tous les appareils qui ont accédé à votre compte Google

Si vous craignez que quelqu’un d’autre ait pu utiliser votre compte, vous pouvez trouver la liste de tous les appareils qui ont accédé à votre compte Google, leur adresse IP et leur emplacement approximatif :

https://security.google.com/settings/security/activity

5. Découvrez toutes les applications et les extensions qui ont accès à vos données Google

Ceci est une liste de toutes les applications qui ont tout type d’accès à vos données. Vous pouvez voir le type exact de permissions accordées à l’application et révoquer l’accès à vos données en suivant ce lien :

https://security.google.com/settings/security/permissions

6. Exportez l’ensemble de vos données de Google

Google vous permet d’exporter toutes vos données : marque-pages, courriels, contacts, fichiers du « Drive », informations de votre profil, vos vidéos YouTube, vos photos et encore davantage :

https://www.google.com/takeout

Tiens et ces options, vous les aviez repérées aussi, vous ?

Bon ça c’est fait. Par petites étapes, on va finir par y arriver !

un service libre en ligne de Framasoft pour présenter et organiser vos idées : Framindmap nouvelle version, dopée aux vitamines du Libre !

On les appelle des mindmaps, c’est-à-dire des cartes mentales ou « cognitives », ou encore « heuristiques ». Elles permettent d’organiser un brainstorming (remue-méninges est une sympathique traduction, non ?), ordonner vos idées à plusieurs, prendre des notes organisées, apprendre et faire apprendre une leçon, réaliser des classifications, identifier les éléments importants… aussi utiles dans l’entreprise que dans le monde de l’enseignement, ces cartes sont réalisables avec un grand nombre de logiciels. Et Framasoft vous propose depuis 2012 les Framindmaps Car si nous voulons Dégoogliser Internet en proposant de nouveaux services, nous n’oublions pas pour autant d’améliorer les services existants… …voici donc une nouvelle version de Framindmap, dopée aux vitamines du libre !

Deux Framindmap en une

Qu’on vous rassure tout de suite, la première version de Framindmap, basée sur le logiciel MindMaps, restera accessible et maintenue. Avec son interface simple (parfaite pour les débutants), la possibilité de créer des cartes heuristiques sans compte et sans laisser vos données sur nos serveurs… il n’était pas question de vous en priver !

Néanmoins, nous avons reçu de nombreuses demandes pour des fonctionnalités qui manquaient à cette première mouture. La possibilité de faire éditer des cartes mentales par vos amis avec une interface plus complète, celle de se créer un compte et de sauvegarder ses cartes mentales en ligne ; ou encore le fait de pouvoir inviter des utilisateurs sur sa carte cognitive, ou de la partager dans un article de blog… Tout cela est rendu possible grâce à l’instance du logiciel Wisemapping que nous mettons désormais à votre disposition.

D’ailleurs, une arborescence valant mieux que de grands discours, voyez plutôt :

C’est l’heure du remue-méninges.

Pour essayer, c’est simple : rendez-vous sur https://framindmap.org et choisissez. En bas, vous retrouverez la version simple et sans création de compte du Framindmap originel ; et en haut vous pourrez vous créer un compte pour créer et sauvegarder vos cartes cognitives plus élaborées… Mais cette nouvelle version reste très facile à prendre en main : vous avez même un tutoriel vidéo pour vous y aider !

Le nouveau Framindmap permet de personnaliser à loisir les couleurs, polices et formes de vos nœuds (les « étiquettes » représentant chaque idée). Vous avez aussi la possibilité d’y ajouter des liens, des notes et des liaisons entre deux nœuds, pour encore plus de précision. Les invitations par email et l’historique des modifications permettent un travail collaboratif sur la même carte heuristique, que l’on peut ensuite exporter dans de nombreux formats, que ce soit les classiques Freeplane/Freemind ou bien les formats texte ou image…

… et si je ne veux pas créer un compte chez Framasoft ?

— Ben vous avez raison ! Comme toutes nos applications en ligne, Framindmap s’inscrit dans le programme « Dégooglisons Internet » où nous voulons proposer des services LEDS :

- Libres (Mindmaps et Wisemapping sont des logiciels libres) ;

- Éthiques (Framindmap est proposé selon nos Conditions Générales d’Utilisation et dans le respect de notre Charte ;

- Décentralisés (on y vient ^^) ;

- Solidaires (il s’agit de logiciels communautaires mis à disposition par une association qui dépend principalement de vos dons).

Nous proposons ce service aux internautes qui ne savent pas (encore) héberger leurs application.

Mais si vous désirez être parfaitement autonomes de la carte heuristique (et on vous y encourage), vous avez sur la page d’accueil de Framindmap accès à un tutoriel concocté par nos soins afin de vous guider dans l’installation de Wisemapping sur vos serveurs. Vous avez aussi accès au site du développement et au git de Framasoftsi vous souhaitez en voir les sources et/ou apporter votre pierre au logiciel.

Participer, c’est remercier.

Il a fallu les efforts conjoints de beaucoup de contributeurs pour vous offrir ce Framindmap sous (libres) stéroïdes ! Alors chez Framasoft, on veut envoyer tout plein de merci-chatons aux créateurs de Wisemapping David Richard , Pablo Luna et Pablo Veiga ainsi qu’à toutes les personnes qui ont contribué à leur code. Merci aussi à Claire Cassaigne pour son tutoriel vidéo de prise en main de Wisemapping. Enfin, un FramaMerci tout particulier à JosephK qui a porté ce projet sur ses épaules pour la communauté Framasoft.

Le meilleur moyen de remercier toutes ces personnes, c’est encore d’utiliser, de partager ces logiciels ! N’hésitez pas à les installer sur votre serveur, ou tarabustez vos copains geeks pour qu’ils le fassent. Ce nouveau Framindmap a vu le jour grâce aux dons des personnes qui soutiennent Framasoft, pensez à faire comme elles en allant là !. Nous sommes certains que ça leur fera honneur, que ça vous rendra service, et que vous réserverez à cette nouvelle version un succès au moins aussi retentissant que celui de la première.

Allez zou ! c’est par là : framindmap*

— et envoyez-nous vos plus chouettes cartes heuristiques !

- disponible aujourd’hui 11/11/2014 à partir de 16h

Ah c’est sûr, tout le monde n’a pas la chance de pouvoir décliner une telle opportunité… Quand on est développeur de haut niveau, c’est plus que flatteur de recevoir une invitation à discuter d’un poste de responsabilité chez le mastodonte du Net. Pour les milliers de développeurs qui sont bien payés à coder pour des produits qui ont des millions (voire des milliards ?) d’utilisateurs, il est assez exaltant de travailler pour Google.

Pourtant, quand Niklas reçoit un message l’invitant à rejoindre une équipe d’ingénieurs chez Google, il a le front de refuser, dans une lettre ouverte où il explique ses raisons.

C’est cet échange de courrier que nous avons traduit pour vous. Notez que cette fois-ci c’est Google qui est sur la sellette (parce qu’il le vaut bien) mais ce pourrait être tout autant un des autres géants du Net centralisateurs et prédateurs de nos données…

source : Why I won’t work for Google sur le blog de Niklas Femerstrand

Traduction Framalang : tetrakos, goofy, Paul, Framasky + 2 anonymes

Voici pourquoi je ne travaillerai pas pour Google

par Niklas Femerstrand

Bonjour Niklas,

Je m’appelle Patrick et je travaille chez Google.

J’ai regardé vos profils Github et LinkedIn, ainsi que votre site personnel (où j’ai découvert le projet panic_bcast), et j’aimerais m’entretenir avec vous à propos d’un certain nombre de postes d’ingénieurs ici chez Google.

Vos contributions et projets open source, votre expérience des systèmes et réseaux et votre expérience de développeur semblent en phase avec ce que font chez nous certains des ingénieurs, mais je souhaite avant tout prendre contact avec vous afin d’en savoir un peu plus sur votre travail.

Si votre emploi du temps le permet, seriez-vous disponible pour un échange la semaine prochaine ?

Les postes dont j’aurais aimé m’entretenir avec vous sont à pourvoir au sein d’une équipe chargée d’un projet sensible qui combine le développement de logiciels et l’expertise en ingénierie des réseaux et systèmes, pour créer et faire fonctionner à grande échelle une infrastructure à tolérance de pannes et des systèmes logiciels massivement distribués.

Merci de m’avoir consacré du temps, je vous souhaite un bon week-end !

Cordialement,

Patrick

Bonjour Patrick,

Merci de m’avoir contacté et pour les compliments sur le projet panic_bcast, c’est toujours flatteur d’être reconnu par plus grand que soi.

Avant de répondre comme il convient à votre question, je voudrais vous donner quelques indications sur mon parcours et mes relations avec Google.

Enfant, j’ai grandi avec l’idée que Google serait toujours l’employeur le plus intéressant que puissent imaginer ceux qui travaillent dans les technologies de l’information. Que Google se conformerait comme par jeu à sa devise « ne rien faire de mal ». J’ai grandi guidé par de fortes convictions et des principes, mais j’étais avant tout curieux par nature. Comme j’étais un enfant intéressé par la sécurité de l’information et les ordinateurs en général, j’ai rapidement commencé à analyser du code en le cassant et des systèmes en m’y introduisant, animé par l’idée que l’information voulait être libre.

Mon père s’en est vite rendu compte et nous avons eu une longue discussion sur ce qui est important dans la vie. Il m’a dit de ne pas être imprudent sinon le monde de demain consisterait en une tyrannie d’une part et des gens dépourvus de pouvoir de l’autre. Il m’a dit que, dans le futur, la répartition des pouvoirs dans le monde dépendrait beaucoup de ceux que je considère aujourd’hui comme des cyberpunks ou des hackers.

J’ai l’impression que l’avenir que mon père me décrivait quand j’étais enfant est aujourd’hui notre présent. Google dit « ne rien faire de mal » d’une part, mais de l’autre Google lit aussi le contenu des messages électroniques de ses utilisateurs et piste leur comportement sur Internet — deux choses que je décrirais clairement comme « le mal ». Google lit les courriels que ma mère écrit et piste ce que mes amis achètent. À des fins publicitaires, prétend Google… mais nous n’en avons découvert les véritables conséquences que plus tard, quand Edward Snowden a lancé l’alerte.

Il s’est avéré que Google avait aidé les services de renseignement américains et européens à pratiquer l’écoute électronique illégale de leurs propres citoyens. « Nous avons essayé de nous défendre, nous avons essayé de ne pas faire de mal », répond Google, mais on n’a jamais vu Google fermer un de ses services pour protester comme l’a fait Lavabit[1].

On n’a jamais vu Google se battre pour le bien de ses utilisateurs, c’est-à-dire la majeure partie de la population du globe.

Nous avons vu Google justifier son espionnage des données en disant que c’était super en termes de stratégie publicitaire.

Nous avons appris que Google fait en réalité des choses très mauvaises pour la majorité de la population mondiale. Nous avons appris que Google a tendance à utiliser une épée à double tranchant. Nous avons appris que le principe « open source autant que possible » de Google ne s’applique que tant qu’il ne perturbe pas le chiffre d’affaires existant.

Nous avons été témoins du fait que Google a envoyé des lettres de mise en demeure[2] aux développeurs et mainteneurs du projet populaire CyanogenMod pour Android pour avoir violé certains brevets en modifiant certains éléments open source d’un projet sous licence open source.

Nous avons appris que l’amitié cordiale de Google n’est qu’une façade publicitaire. Nous avons appris que Google n’est pas ce que nous pensions, qu’il ne se bat pas pour le bien de l’humanité mais pour le bien de son portefeuille.

C’est en cela que je me distingue de Google. Mes principes ne sont pas compatibles avec ceux que Google suit et a suivis tout au long de son histoire.

En vertu de mes principes, j’effacerais plutôt que collecterais toutes les données que Google, lui, rassemble sur ses utilisateurs, à savoir moi, ma famille, mes amis, mes collègues et toute personne dont Google sait qu’elle se connecte et a recours à des services populaires sur l’Internet public. Il me serait difficile de trouver le sommeil si je travaillais pour une entreprise qui cible les gens que j’aime et les menace directement.

Je me vois mal développer un jour les outils tyranniques indispensables à Google pour continuer sa course. Je suis de l’autre bord. J’ai conçu le projet que vous saluez, panic_bcast, pour que les services de sécurité aient davantage de difficultés à récolter des informations sur des militants politiques au moyen d’attaques du type « démarrage à froid ». Ce qui motive ma participation à d’autres projets de ce genre est ma conviction de la nécessité d’une circulation libre et sans contraintes de l’information sur l’Internet public.

Je fais partie des ces personnes assez chanceuses pour pouvoir se permettre de choisir les projets sur lesquels elles ont envie de travailler et je choisis de ne m’impliquer que dans des projets dont j’ai la conviction qu’ils apportent une contribution positive à la population dans le monde. Google n’occupe pas une place très élevée dans ma liste à cet égard et je suis au regret d’avoir à décliner votre proposition d’emploi.

« Les gens bien élevés ne lisent pas le courrier des autres »

— Henry L. Stimson

Je vous souhaite bonne chance dans votre recherche du candidat idéal.

Cordialement,

Niklas

Notes

[1] Lavabit est une entreprise américaine qui a préféré arrêter ses activités plutôt que de se soumettre à un mandat de recherche du gouvernement des États-Unis. Lavabit fournissait un service de messagerie électronique sécurisé par un chiffrement de haut niveau, c’est une adresse @lavabit qu’utilisait Edward Snowden. Davantage de détails sur la page Wikipédia de Lavabit.

[2] Une procédure judiciaire d’injonction expliquée sur cette page.